Архивирование веб-сайтов (Gj]nfnjkfguny fyQ-vgwmkf)

Архиви́рование веб-сайтов (веб-архиви́рование, англ. web archiving) — процесс сбора и «дублирования» веб-страниц и целых сайтов с целью сохранения информации и доступа к ней в будущем, если источник окажется недоступен. Предпосылками для развития веб-архивирования стали проблемы вымирания ссылок и потенциальное наступление цифрового тёмного века. В 1996 году был создан «Архив Интернета» — первая некоммерческая организация, поставившая перед собой цель создать «снимки» всех страниц в интернете. В 2001 году «Архив» запустил сервис по архивированию сайтов Wayback Machine, через который по состоянию на 2021-й год было сохранено более 600 млрд веб-страниц.

С начала 2000-х годов практики сохранения веб-сайтов активно внедряют во многих странах, в том числе и на государственном уровне. При этом действуют площадки по разработке стандартов и общих практик в сфере веб-архивирования, включая Международный семинар архивирования Интернета (IWAW) (с 2001-го) и Международный консорциум сохранения интернета[англ.] (с 2003-го).

Чаще всего информацию со статических сайтов собирают с помощью поисковых роботов (например, Heritrix[англ.], Webrecorder, HTTrack), которые отправляют HTTP-запросы на веб-сервера и «захватывают» передаваемый контент и все гиперссылки из просканированных веб-страниц. Напротив, скрипты, шаблоны и контент динамических сайтов хранится на веб-серверах как отдельные ресурсы, поэтому архивировать такие порталы гораздо сложнее. Процесс проходит в два основных этапа — сохранение файловых данных из структуры каталогов веб-сайта и последующее архивирование информации из базы данных.

Определение

[править | править код]Термины веб-архивирование и веб-сохранение (англ. web preservation) часто используют как взаимозаменяемые, однако между ними существует важное различие: первый определяет весь процесс сохранения интернет-ресурса, а второй — только один из этапов[1]. Международный Консорциум Сохранения Интернета[англ.] (IIPC) определяет веб-архивирование как:

[...] процесс сбора частей всемирной паутины, сохранение коллекций в архивном формате и последующее обслуживание архивов с целью предоставления к ним доступа и использования.

Предпосылки

[править | править код]

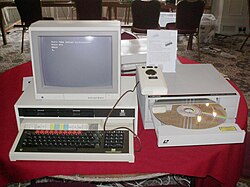

С начала 1990-х годов создание, хранение и распространение информации происходит в основном в цифровой среде. Уже к середине 1990-х годов начали устаревать ранее популярные носители информации, такие как магнитные ленты, дискеты, zip-накопители и компакт-диски, а доступ к старым файловым форматам затруднялся[2][3]. Стали исчезать многие крупные базы данных, которые не были скопированы на другие носители или продублированы на бумаге[4]. Так, все данные крупномасштабного проекта BBC Domesday Project, проведённого в 1980-е годы при участии более миллиона человек, были записаны на несколько дисков, которые к началу 2000-х годов были либо сломаны, либо потеряны[5][6].

Повсеместная утеря данных привела к тому, что отдельные исследователи начали обсуждать потенциальное наступление «цифрового тёмного века» (англ. digital dark age) — периода, характеризуемого практически полным отсутствием письменных свидетельств[7][8]. Некоторые исследователи называют XXI век «информационной чёрной дырой» из опасения, что программное обеспечение и компьютеры будущего не смогут воспроизвести созданные ранее данные[9]. В 2003 году ЮНЕСКО выпустила «Хартию о сохранении цифрового наследия»[10], определяющую важность резервации цифровых данных, потеря которых может привести к «обеднению» человеческого наследия[11][12]. В 2015 году с заявлением о том, что человечество движется к «цифровому тёмному веку», выступил американский учёный и вице-президент Google Винтон Серф[13][14][15][16].

Другой предпосылкой для развития веб-архивирования является вымирание ссылок — ситуация, когда страницы становятся недоступны по прежним URL или изменяются их содержание[17][18][19]. Проведённый португальскими исследователями в 2017 году анализ показал, что около 80 % интернет-страниц недоступны в исходном виде уже спустя год после публикации, при этом 13 % ссылок в научных статьях исчезали в среднем через 27 месяцев[11]. В 2021 году учёные юридического факультета Гарвардского университета вместе с журналистами The New York Times (NYT) проанализировали жизнеспособность ссылок в более чем 550 тысячах выпущенных NYT онлайн-публикациях в период за 2000—2017 годы — около четверти используемых URL-адресов «вымерли»[20][21][22][23][24]. Средняя продолжительность жизни веб-страницы составляет 44-100 дней, а на новостных сайтах и в социальных сетях информация может исчезать ещё быстрее[25][26].

Информация в интернете может исчезать и по другим причинам. Так, в 2015 году Государственный департамент США и Агентство США по международному развитию инициировали удаление материалов о войне в Афганистане с целью уберечь сотрудничавших с американскими властями людей от преследования талибами[27]. Другой пример — выдвинутые в декабре 2021 года требования Роскомнадзора удалить из ряда российских СМИ материалы о расследованиях издания «Проект», ранее признанного нежелательной организацией[28][29].

Развитие

[править | править код]Начиная с 1980-х годов отдельные архивы и библиотеки начали сохранять электронные ресурсы с целью задокументировать хронику актуальных событий. Однако отправной точкой веб-архивирования считается создание в 1996 году «Архива Интернета» — некоммерческой организации, поставившей амбициозную цель сохранить все веб-страницы всего интернета, которых в тот момент было относительно немного[30][1]. В конце 1990-х — начале 2000-х годов правительства многих развитых стран стали внедрять практики веб-архивирования, возложив ответственность за их ведение на национальные библиотеки, обладающие необходимым опытом и инструментами для архивации[31][11][12]. К 2000 году национальные веб-архивы появились во многих странах, включая Великобританию, Новую Зеландию, США и Чехию[32][33][19].

С тех пор количество проектов по веб-архивированию растёт с каждым годом[11]. В 2011 году в мире действовало 42 программы, большинство из которых занимались сбором региональных веб-источников[12]. Исследование 2020 года показало экспоненциальный рост числа учреждений, имеющих собственные репозитории, работа которых поддерживается благодаря нанятым специалистам и специализированному оборудованию. Большинство таких репозиториев пополняется по принципу самоархивирования — авторы самостоятельно размещают там свои материалы[34]. К 2019 году веб-архивы на национальном уровне были внедрены практически во всех странах Европейского союза, чаще всего — в рамках работы национальных библиотек[32][35].

Организации

[править | править код]«Архив Интернета»

[править | править код]

Первой крупнейшей инициативой по веб-архивированию стал «Архив Интернета» — некоммерческая организация, созданная в 1996 году для сохранения всех размещённых в интернете материалов[19]. Создателем стал американский программист Брюстер Кейл, одновременно запустивший «Архив» и коммерческую систему веб-архивирования Alexa Internet. В 1997 году он разработал браузерный плагин, через который Alexa Internet автоматически определяла и сохраняла в «Архив» «ценные» веб-страницы, ранжируя их по количеству посещений, перекрёстных ссылок и «кликов»[36]. С 1998 года количество страниц для архивации увеличивалось вдвое каждые 3—6 месяцев[37].

24 октября 2001 года «Архив Интернета» запустил сервис Wayback Machine, через который пользователи могли получить доступ к более чем 10 млрд заархивированных веб-страниц. В то время данные хранились на серверах Hewlett Packard и uslab.com и управлялись через операционные системы FreeBSD и Linux[37].

На 2024 год коллекция «Архива» состояла из множества подколлекций архивированных веб-сайтов, оцифрованных книг, аудио и видео файлов, игр, программного обеспечения[38]. При этом число заархивированных веб-страниц составило более 900 млрд[39].

WebCite

[править | править код]Сервис WebCite был запущен в 2003 году и стал первым инструментом веб-архивирования, позволяющим пользователям сохранять веб-сайты по запросу. WebCite быстро набрал популярность и уже к 2005 году около 200 журналов просили авторов архивировать используемые веб-страницы через WebCite перед отправкой рукописей[40]. Сервис не использует поисковых роботов для «захвата» страниц, архивация происходит напрямую по запросу пользователя[40].

В 2013 году WebCite был под угрозой закрытия из-за недостатка финансирования, однако благодаря публичной кампании по сбору средств создателя Гюнтера Айзенбаха портал продолжал свою работу ещё шесть лет. С 2019 года он стал доступен только для чтения и перестал принимать запросы на архивацию[41][42].

Archive.today

[править | править код]Сервис archive.today (при создании — archive.is) был запущен в 2012 году одноимённой некоммерческой организацией[43]. Финансирование проекта осуществляется на деньги частных спонсоров. Также как и WebCite, archive.today сохраняет веб-страницы по запросу пользователей[44][45], размещая в открытом доступе функциональную копию веб-страницы и снимок экрана, представляющий статичную визуализацию страницы в формате PNG[46]. Размер заархивированной страницы со всеми изображениями не должен превышать 50 МБ[43].

Создатели archive.today также запустили специальное расширение браузера Mozilla Firefox, автоматически сохраняющее и выкладывающее в общий доступ копии каждой добавляемой пользователем в закладки веб-страницы[46][47].

Национальные библиотеки

[править | править код]В большинстве развитых стран действуют законы об обязательном экземпляре, возлагающие юридическую ответственность на национальные библиотеки сохранять один экземпляр каждого опубликованного в этой стране печатного издания. С повсеместным развитием средств электронной коммуникации действие закона распространили и на веб-сайты[1][48]. Так, согласно Закону о публичных записях 1967 года[англ.], Национальные архивы Великобритании[англ.] и Ирландии[англ.] обязаны сохранять все важные постановления правительства Великобритании. Поскольку чиновники всё чаще публикуют свои отчёты в интернете, веб-архив ежемесячно посещают более 100 млн пользователей (на 2013-й год)[25].

В 1996 году Национальная библиотека Швеции инициировала проект Kulturar, в рамках которого осуществлялось крупномасштабное сохранение всей шведской сети доменов[49]. К началу 2005 года было собрано более 350 000 веб-сайтов или около 10 терабайт данных, благодаря чему веб-архив стал крупнейшим на тот момент в мире[19]. В 1997 году была создана совместная инициатива национальных библиотек Дании, Финляндии, Исландии, Норвегии, Швеции под названием Nordic Web Archive (NWA). В рамках NWA велась разработка инструментов и обсуждались методы веб-архивирования для скандинавских стран. В 2004 году NWA выпустил программный пакет для доступа к архивированным веб-документам, который впоследствии лёг в основу IIPC[англ.] Toolkit[19][50]. В этом же году Национальная библиотека Австралии запустила Pandora[англ.] — проект по сохранению электронных ресурсов Австралии[51][52][19]. В 2019 году коллекция Pandora вошла в Australian Web Archive[англ.] — один из крупнейших национальных веб-архивов в мире[53].

Коллаборации

[править | править код]

В 2001 году был создан Международный семинар архивирования Интернета (IWAW)[54] — площадка по обмену исследованиями и опытом в сфере веб-архивирования[55], а в 2003-м по инициативе «Архива Интернета» основали Международный Консорциум Сохранения Интернета[англ.], в рамках которого ведётся разработка стандартов и инструментов веб-архивирования[37][56]. Помимо «Архива», в состав IIPC вошли национальные библиотеки Франции, Австралии, Канады, Дании, Финляндии, Исландии, Италии, Норвегии, Швеции, Великобритании, США. В 2008-м в рамках IIPC был разработан Web ARChive или WARC — формат для архивации веб-ресурсов[12]. На 2021 год в IIPC состояло более 50 членов[57].

Организации часто сотрудничают для создания объединённых веб-архивов. Так, с 2004 по 2018 год действовал Европейский цифровой архив (впоследствии переименованный в Internet Memory Foundation[англ.]), занимающийся сбором электронных документов в странах Европейского союза[58][19][12]. Среди прочих, в его состав входили Национальные архивы Великобритании, Общество Макса Планка, Берлинский технический университет, Саутгемптонский университет, Institut Mines-Télécom[англ.]. В начале 2000-х годов департаменты китаеведения Гейдельбергского и Лейденского университетов совместно запустили веб-архив DACHS, содержащий электронные материалы по синологии[59][19]. Такие консорциумы как NWA и UKWAC проводили программы совместного сбора данных в партнёрстве с другими организациями[60][19][61]. В конце 1990-х годов Европейская комиссия профинансировала создание Networked European Deposit Library (NEDLIB) — проекта по сбору, описанию, хранению и открытию доступа к сохранённым европейским веб-сайтам[62]. Выпущенный в 2000 году NEDLIB Harvester стал одним из первых поисковых роботов, специально созданных для архивации данных. Впоследствии его использовали в ряде проектов, в том числе для сбора данных с нидерландских, эстонских и исландских веб-доменов[19][63].

В июле 2011 года Национальный архив Великобритании совместно с Internet Memory Foundation запустили пилотный проект по веб-архивированию цифровых данных для местных органов власти. Проект действовал в семи архивах муниципальных образований, охватывающих более 20 местных органов власти. Персонал прошёл бесплатное обучение по созданию кураторского веб-архива для своей области[64].

Университеты развитых стран также участвуют в развитии веб-архивирования. Например, в Мичиганском , Индианском, Калифорнийском, Иллинойсском и других университетах предлагают курсы по обучению архивации цифровых материалов[54], а несколько учреждений создали собственные веб-архивы для исследовательских целей — Stanford WebBase Archive (Стэнфордский университет), Socio-Sense (Токийский университет), веб-информационный центр (Пекинский университет)[12].

Отбор источников

[править | править код]Перед началом архивации каждая организация определяет критерии «отбора» источников. Таких критериев может быть один или несколько, в зависимости от размера и целей организации[19][65]. Некоторые веб-архивы, такие как «Архив Интернета», ставят перед собой цель собрать все возможные веб-страницы — такой подход называют неселективным или широким сканированием. В его основе лежит принцип взаимосвязанности всемирной паутины, согласно которому по-настоящему «сохранить» какую-либо тему можно только собрав все существующие веб-страницы, так как они все связаны между собой. Помимо этого, отбор веб-сайтов является дорогостоящим и трудоёмким процессом, который также может привести к субъективной выборке[19]. Однако подход «Архива» считается невыполнимым на практике — сохранение всех страниц невозможно из-за ограничений, связанных с авторским правом, и даже «Архив Интернета» сохраняет только доступные общественности материалы[66].

Альтернативой неселективному подходу к отбору является выборочный подход или выбор ресурсов, основываясь на их принадлежности к заранее заданным критериям — домену (например, .gov или .edu), теме, событию, типу мультимедиа или жанру[19]. Выборочный подход часто совмещают с практиками широкого сканирования — например, если организация архивирует все порталы с определённым доменным именем. Так, Национальная библиотека Швеции с 1996 года производит сбор всех веб-сайтов с доменом «.se»[19][67], а Национальная библиотека Великобритании архивирует веб-сайты с доменами «.gov.uk», «.org.uk» и «.co.uk». Библиотека НАСА Центра космических полётов Годдарда сохраняет все веб-страницы с доменным именем Центра[19]. Главным преимуществом выборочного архивирования является то, что такой подход позволяет создать более управляемые по размеру коллекции со связанными ресурсами[19].

Выборочный подход применяют и для создания тематических коллекций. Например, DACHS собирает социальные и культурные ресурсы по синологии, а Библиотека Конгресса, совместно с Архивом Интернета, скомпилировала веб-архивы о президентских выборах в США и событиях 11 сентября. Британская библиотека специализируется на веб-сайтах, представляющих «ценность для национальной культуры»[67]. Такой подход применяет и проект Pandora Национальной библиотеки Австралии[19][54]. В 2006 году «Архив Интернета» запустил сервис Archive It по созданию тематических веб-коллекций[68], которым зачастую пользуются отдельные организации, например, Национальный музей женского искусства[69].

Некоторые организации архивируют ресурсы по типу представленных источников. Так, библиотека Центра космических полётов Годдарда избегает сканирования больших видеофайлов и программных продуктов. Наоборот, другие проекты веб-архивируют видео на Youtube или собирают блоги, виртуальные газеты — например, Национальная библиотека Франции создала отдельную веб-коллекцию для Живых Журналов[54].

Сбор данных

[править | править код]Статические сайты

[править | править код]Чем проще и статичнее сайт, тем легче его архивировать[70] — копии данных загружаются с веб-сервера в виде файлов, которые впоследствии можно преобразовать в другие форматы[71][72][73].

Процесс автоматического сбора веб-страниц через поисковых роботов называют web harvesting или «сканированием». Роботу передают список URL-адресов, следуя по которым он отправляет HTTP-запросы на веб-сервера и «захватывает» передаваемый контент и все гиперссылки из просканированных веб-страниц[73]. Затем автоматизированное ПО преобразует информацию в формат WARC, и в итоге получается файл, который можно воспроизвести с помощью таких инструментов, как Wayback Machine[74]. Примерами поисковых роботов являются разработанный «Архивом Интернета» в 2004 году Heritrix[англ.][75], а также HTTrack[76] и Wget[77]. Сеть «сканеров» позволяет организациям сохранять копии выбранных сайтов с некоторой периодичностью — например, ежедневно или ежегодно[74]. Для более точечного архивирования используют инструменты меньшего масштаба — например, HTTrack, который позволяет загружать копии веб-сайтов на локальный компьютер[74].

Динамические сайты

[править | править код]Архивировать динамические сайты гораздо сложнее, чем статические, поскольку контент, скрипты и шаблоны хранятся на веб-сервере как отдельные ресурсы. а вид и содержимое страницы формируется в зависимости от браузера клиента и настроек сервера. В отличие от статических веб-сайтов, автоматической обработки HTTP-запроса недостаточно, поскольку со стороны сервера сайт генерирует контент, используя базу данных[71]. Поэтому сохранение таких ресурсов происходит в два этапа — сохранение файловых данных, находящихся в структуре каталогов веб-сайта, и архивирование информации базы данных[71]. Для динамических сайтов использование поисковых роботов имеет свои ограничения[19]. К инструментам веб-архивирования динамического контента относят программные обеспечения Software Independent Archiving of Relational Databases (SIARD), разработанное Швейцарским федеральным Архивом, и DeepArc Национальной библиотеки Франции. SIARD автоматически анализирует и отображает структуру исходной базы данных. Затем он экспортирует структуру в виде текстового файла, содержащего определение данных, описанное с использованием SQL — международного стандарта для описания реляционной базы данных. Впоследствии содержимое экспортируется в качестве обычного текстового файла, а метаданные сохраняются как XML-документ[19].

Архивация социальных сетей

[править | править код]Первые проекты по архивированию социальных сетей начали появляться с 2008 года как систематическое широкое сканирование платформ. Так, Национальная библиотека Новой Зеландии начала работу по созданию архива опубликованных в Твиттере сообщений, а Национальная библиотека Франции сканировала Facebook. Однако из-за большого объёма производимого контента, отсутствия технических стандартов по сбору и хранению информации, а также постоянно меняющихся технических деталей работы порталов, впоследствии организации начали применять выборочный подход к веб-архивированию социальных сетей и сохранять сообщения только о конкретных событиях или чрезвычайных ситуациях. Отдельные организации, например, Национальная библиотека Франции или Национальная библиотека Канады, запустили непрерывный автоматизированный сбор новостей и контента социальных сетей, чтобы не упустить реакцию людей на непредвиденные события. Выборка осуществляется по заданным хештегам или ключевым словам, за определённый период или конкретной платформе[78][79].

Инструменты

[править | править код]

Для сбора веб-сайтов используют различные инструменты веб-архивирования. Наиболее часто встречается поисковой робот Heritrix — доступный по лицензии свободного программного обеспечения веб-сканер общего назначения, разработанный с учётом задач веб-архивирования. Heritrix сохраняет файлы в формате WARC и хорошо подходит для крупномасштабных операций сканирования, однако в меньшей степени «захватывает» динамические сайты или страницы в социальных сетях. Разработанный на основе Heritrix NetarchiveSuite предоставляет дополнительные функции в области долгосрочного хранения и доступа к материалам[1].

Webrecorder использует браузер для сбора содержимого веб-сайтов, тем самым решая частые проблемы других поисковых роботов — захват динамического контента, Adobe Flash, мультимедиа. Программа «записывает» веб-страницы во время их просмотра пользователем, поэтому хорошо подходит для выборочного сканирования. Содержание также сохраняется в формате WARC[1]. Другой поисковой робот, Brozzler[80], использует движок браузера Google Chrome для сбора страниц и предлагает те же преимущества, что и Webrecorder, но не требует взаимодействия с пользователем во время сканирования[1].

HTTrack позволяет загружать копии веб-сайтов на локальный компьютер, и впоследствии пользователь может просмотреть их через браузер[81]. Wget и аналогичный инструмент Wpull — универсальные инструменты командной строки, которые имеют встроенные функции сканирования веб-страниц, сравнимые с HTTrack. Wpull лучше подходит для масштабного архивирования[1].

Из-за динамической структуры сайтов социальных сетей для их архивации требуются специализированные инструменты. Обычно веб-архивирование выполняется с использованием интерфейсов прикладного программирования или API, предоставляемых разработчиками. F (b) arc — инструмент командной строки, который можно использовать для архивирования данных с помощью интерфейса Facebook Graph. Twarc — инструмент и библиотека командной строки, которые упрощают использование API-интерфейсов Twitter. Social Feed Manager позволяет собирать данные из Twitter, Tumblr, Flickr и Sina Weibo[1].

Чаще всего для архивирования используют форматы ARC и WARC. Большинство инициатив используют решения на основе Lucene для поддержки полнотекстового поиска, включая NutchWAX или Solr, Wayback Machine для поддержки поиска URL и отображения заархивированного контента[11]. Инструменты JWAT, node-warc, WARCAT, warcio и warctools могут быть использованы для чтения и извлечения метаданных из файлов WARC[1].

Разрешение

[править | править код]Будет ли организация подчиняться стандарту исключений для роботов или запрашивать разрешение на архивирование у владельцев сайта, зависит от многих факторов — вида контента, масштабов веб-архивирования, правовой среды[54][1]. Однако даже при обращении за разрешением только около 30—50 % владельцев сайтов откликаются на просьбу[82].

Как правило, правительственные организации, наделённые законным правом хранить публичные записи (например, Национальное управление архивов и документации (США) и Национальные архивы Великобритании), не нуждаются в разрешении на сканирование. Согласно французскому закону об авторском праве от 2006 года, Национальная библиотека Франции может игнорировать роботов при сканировании сайтов с национальными доменами[54][1]. Другие организации, такие как «Архив Интернета», в своей работе используют принцип отказа — данные удаляются из коллекции по просьбам правообладателей, которые могут доказать авторские права, предоставив описание материала, контактные данные заявителя и подписанное заявление[83][54][25].

Метаданные

[править | править код]Веб-архивы обычно имеют иерархическую структуру — сеанс сканирования захватывает множество сайтов, каждый из которых ведёт на отдельную веб-страницу, содержащую видео, текст и файлы изображений. Для каждого из «уровней» генерируются метаданные[54][19].

Подход к созданию метаданных зависит от масштаба и ресурсов, которыми обладает организация. Так, крупные веб-архивы часто полагаются на автоматическое создание метаданных. Некоторые метаданные, включая время сбора, код состояния (например, ошибка 404 для не найденного или 303 для перенаправления), размер в байтах, URI или тип MIME (например, text/HTML), автоматически «захватываются» поисковыми роботами. Информация также может быть извлечена из метатегов HTML-страниц[54][19].

Небольшие веб-архивы могут генерировать метаданные вручную. Литературный архив Калифорнийского университета в Лос-Анджелесе использует подробные заметки, созданные персоналом в процессе сбора и анализа веб-страниц, для генерации метаданных[54][84]. В веб-архиве Национального университета Тайваня действует трёхуровневая иерархическая классификация. Метаданные могут также могут быть созданы с помощью пользовательских тегов, комментариев или оценок[54][84][85].

Проблемы

[править | править код]Пользователи обращаются к веб-архивам по разным причинам — для проведения исследований, компиляции собственной базы данных или просмотра старых версий отдельных веб-ресурсов. Однако зачастую доступ к таким коллекциям осложнён отсутствием общего поиска по доступным базам данных и неудобным интерфейсом. Для доступа и обработки сохранённой информации часто требуются технические навыки работы со специализированными форматами файлов[86][61][87]. Отдельные исследователи считают, что именно по этим причинам ссылки на веб-архивы по-прежнему редко встречаются в научных работах, а коллекции — не изучаются[88][89].

Коллекция веб-архива может оказаться неполной или предвзятой из-за невозможности заархивировать «закрытые» сайты и/или непрофессиональной разработки стратегий архивирования — например, когда архивируют только англоязычные порталы крупных западных стран. Несмотря на то, что часть архивов имеет юридическое право игнорировать стандарт исключений для роботов, коллекции остальных организаций существенно лимитированы при соблюдении стандарта[70][90][70].

Автоматическое веб-архивирование через использование поисковых роботов позволяет «захватить» большое количество информации[34], однако некоторые интерактивные элементы JavaScript сохранить невозможно и архивная версия теряет свою функциональность[70][91].

Примечания

[править | править код]- ↑ 1 2 3 4 5 6 7 8 9 10 11 Chambers, 2019, pp. 85—111.

- ↑ Veronique Greenwood. The digital Dark Ages (англ.). Yale Alumni Magazine (июнь 2020). Дата обращения: 9 декабря 2021. Архивировано 15 октября 2021 года.

- ↑ Dan Greene. The erosion of personal ownership (англ.). Vox (21 апреля 2021). Дата обращения: 9 декабря 2021. Архивировано 26 сентября 2021 года.

- ↑ Digital Domesday Book lasts 15 years not 1000 (англ.). The Guardian (3 марта 2002). Дата обращения: 11 декабря 2021. Архивировано 20 января 2013 года.

- ↑ Veronique Greenwood. The digital Dark Ages (англ.). Yale Alumni Magazine (июнь 2020). Дата обращения: 27 сентября 2021. Архивировано 15 октября 2021 года.

- ↑ Lamont Wood. Fending off the digital dark ages: The archival storage issue (англ.). ComputerWorld (26 августа 2010). Дата обращения: 11 декабря 2021. Архивировано 26 января 2021 года.

- ↑ Giaretta, 2011.

- ↑ Panos, 2003.

- ↑ Adam Wernick. Scientists warn we may be creating a 'digital dark age' (англ.). The World (1 января 2018). Дата обращения: 10 декабря 2021. Архивировано 16 августа 2021 года.

- ↑ Хартия о сохранении цифрового наследия (англ.). ООН. Дата обращения: 12 декабря 2021. Архивировано 23 августа 2021 года.

- ↑ 1 2 3 4 5 Costa, 2017, pp. 191—205.

- ↑ 1 2 3 4 5 6 Toyoda, 2012, pp. 1441—1443.

- ↑ To avoid a digital dark age, all stakeholders must put their heads together (англ.). The Times of India (17 сентября 2020). Дата обращения: 27 сентября 2021. Архивировано 8 сентября 2021 года.

- ↑ Lauren Maffeo. Google's Vint Cerf on how to prevent a digital dark age (англ.). The Guardian (29 мая 2015). Дата обращения: 27 ноября 2021. Архивировано 19 ноября 2021 года.

- ↑ Dave Smith. Father of the internet: 'If we don’t move now, we risk losing all the data we’ve created in the 21st century' (англ.). Business Insider (20 февраля 2015). Дата обращения: 28 ноября 2021. Архивировано 19 ноября 2021 года.

- ↑ Николай Удинцев. Цитата дня: почему может начаться «цифровой Тёмный век» (англ.). Look at Me (13 февраля 2015). Дата обращения: 28 ноября 2021. Архивировано 19 ноября 2021 года.

- ↑ Adoghe, 2013, pp. 598—603.

- ↑ Perkel, 2015, pp. 111—112.

- ↑ 1 2 3 4 5 6 7 8 9 10 11 12 13 14 15 16 17 18 19 20 21 Brown, 2006, pp. 1—256.

- ↑ Rhodes, 2010, pp. 581—597.

- ↑ White, 2019, pp. 29—43.

- ↑ Исследователи указали на проблему «вымирания» ссылок в Интернете (англ.). Вести (21 мая 2021). Дата обращения: 28 сентября 2021. Архивировано 23 ноября 2021 года.

- ↑ Bowers, 2021.

- ↑ Mitchell Clark. New research shows how many important links on the web get lost to time (англ.). The Verge (21 мая 2021). Дата обращения: 10 октября 2021. Архивировано 20 июня 2021 года.

- ↑ 1 2 3 Pennock, 2013.

- ↑ Nick Bilton. The Lifespan of a Link (англ.). The New York Times (7 сентября 2011). Дата обращения: 10 декабря 2021. Архивировано 28 сентября 2021 года.

- ↑ Matthew Gault. The US Is Removing Records of Its War in Afghanistan From the Internet (англ.). Vice (17 июля 2015). Дата обращения: 11 декабря 2021.

- ↑ Роскомнадзор потребовал от СМИ удалить публикации о расследованиях "Проекта", признанного нежелательной организацией. BBC (18 декабря 2021). Дата обращения: 20 декабря 2021. Архивировано 18 декабря 2021 года.

- ↑ Тася Елфимова. Роскомнадзор потребовал от The Village, «Медузы» и «Дождя» удалить десятки новостей по расследованиям «Проекта». The Village (18 декабря 2021). Дата обращения: 19 декабря 2021. Архивировано 18 декабря 2021 года.

- ↑ Patel, 2020, pp. 1—10.

- ↑ Балацкая, 2021, с. 12—16.

- ↑ 1 2 Pretoro, 2013, pp. 63—67.

- ↑ Single Sites Web Archive - Minerva - Library of Congress Web Archive (англ.). European History Primary Sources. Дата обращения: 13 декабря 2021. Архивировано 6 мая 2021 года.

- ↑ 1 2 Rockwell, 2020, pp. 1—17.

- ↑ Mark Pesce. Archiving the World Wide Web (англ.). Cosmos (29 октября 2021). Дата обращения: 11 декабря 2021. Архивировано 25 ноября 2021 года.

- ↑ Kimpton, 2006.

- ↑ 1 2 3 Masanes, 1998, pp. 201—212.

- ↑ Rory Carroll. Brewster's trillions: Internet Archive strives to keep web history alive (англ.). The Guardian (26 апреля 2013). Дата обращения: 11 декабря 2021. Архивировано 15 декабря 2021 года.

- ↑ Wayback Machine (англ.). Wayback Machine. Дата обращения: 31 декабря 2024.

- ↑ 1 2 Trudel, 2005.

- ↑ Fund WebCite (http://www.webcitation.org) (англ.). FundRz. Дата обращения: 18 декабря 2021.

- ↑ Archive Now (archivenow) (англ.). GitHub. Дата обращения: 20 декабря 2021. Архивировано 20 декабря 2021 года.

- ↑ 1 2 FAQ (англ.). archive.ph. Дата обращения: 10 декабря 2021. Архивировано 27 октября 2021 года.

- ↑ Salman Ravoof. How to Archive a Website: Our Mammoth Guide to Saving Your Site (англ.). Kinsta (3 ноября 2021). Дата обращения: 7 декабря 2021. Архивировано 5 ноября 2021 года.

- ↑ Jason Koebler. Dear GamerGate: Please Stop Stealing Our Shit (англ.). Vice (29 октября 2014). Дата обращения: 7 декабря 2021. Архивировано 27 ноября 2021 года.

- ↑ 1 2 Martin Brinkmann. Create publicly available web page archives with Archive.is (англ.). G Hacks (22 апреля 2015). Дата обращения: 12 декабря 2021. Архивировано 12 апреля 2019 года.

- ↑ Comparison of web archiving services (англ.). Web Page Archiving. Дата обращения: 10 декабря 2021. Архивировано из оригинала 22 сентября 2013 года.

- ↑ Система электронного обязательного экземпляра в Великобритании (англ.). Информационно-аналитический журнал Университетская Книга (21 сентября 2013). Дата обращения: 18 декабря 2021. Архивировано 24 октября 2020 года.

- ↑ The Kulturarw3 Project (англ.). Jeremy Norman's History of Information. Дата обращения: 10 декабря 2021.

- ↑ NWA Toolset 1.1RC10 released (англ.). NWA. Дата обращения: 11 декабря 2021. Архивировано 26 апреля 2018 года.

- ↑ History (англ.). Pandora. Дата обращения: 11 декабря 2021. Архивировано 4 июня 2020 года.

- ↑ Webb, 2000, pp. 154—172.

- ↑ George Nott. National Library launches 'enormous' archive of Australia's Internet (англ.). Computer World (11 марта 2019). Дата обращения: 10 декабря 2021. Архивировано 24 ноября 2021 года.

- ↑ 1 2 3 4 5 6 7 8 9 10 11 Niu, 2012.

- ↑ IWAW 2010 : The 10th Intl Web Archiving Workshop (англ.). WikiCfP. Дата обращения: 15 декабря 2021. Архивировано 27 апреля 2021 года.

- ↑ International Internet Preservation Consortium (англ.). International Internet Preservation Consortium. Дата обращения: 14 декабря 2021. Архивировано 14 декабря 2021 года.

- ↑ IIPC members (англ.). International Internet Preservation Consortium. Дата обращения: 13 декабря 2021. Архивировано 16 декабря 2021 года.

- ↑ European archive (англ.). Library of Congress. Дата обращения: 13 декабря 2021.

- ↑ About DACHS (англ.). Bereichbibliother Ostaasien. Дата обращения: 13 декабря 2021. Архивировано 17 октября 2021 года.

- ↑ Steve Bailey, Dave Thompson. Building the UK's First Public Web Archive (англ.). D-lib Magazine (2006). Дата обращения: 18 декабря 2021. Архивировано 23 ноября 2021 года.

- ↑ 1 2 Dooley, 2017, pp. 1—15.

- ↑ Johan Steenbakkers. Presentations (англ.). European Library Automation Group. Дата обращения: 13 декабря 2021. Архивировано 29 декабря 2021 года.

- ↑ Hakala, 2001, pp. 211—216.

- ↑ Duncan Jefferies. Using web archives to preserve the past. The Guardian (9 марта 2012). Дата обращения: 11 декабря 2021. Архивировано 10 июня 2021 года.

- ↑ Alam, 2020, pp. 1—251.

- ↑ Broussard, 2021, p. 276.

- ↑ 1 2 Chambers, 2019.

- ↑ Поврозник, 2020, с. 95—102.

- ↑ Slania, 2013, pp. 112—126.

- ↑ 1 2 3 4 João Miranda. Web Harvesting and Archiving (англ.). Web Ist UTL. Дата обращения: 17 декабря 2021. Архивировано 29 декабря 2021 года.

- ↑ 1 2 3 Rumianek, 2013.

- ↑ Brunelle, 2012.

- ↑ 1 2 Pretoro, 2013.

- ↑ 1 2 3 Preserving the Web (англ.). Digital Preservation Online. Дата обращения: 17 декабря 2021. Архивировано 14 сентября 2021 года.

- ↑ Mohr, 2004, pp. 1—15.

- ↑ Justin Kulesza. How to Archive a Website (англ.). Atomic Object. Дата обращения: 14 декабря 2021. Архивировано 23 июня 2016 года.

- ↑ The command I use to archive a single website (англ.). GitHub. Дата обращения: 15 декабря 2021. Архивировано 23 декабря 2021 года.

- ↑ Michel, 2021, pp. 107—128.

- ↑ Редькина, 2019, с. 52.

- ↑ internetarchive/brozzler (англ.). GitHub. Дата обращения: 16 декабря 2021. Архивировано 10 декабря 2021 года.

- ↑ Путеводитель по offline-браузерам. Часть 2. IXBT.com. Дата обращения: 17 декабря 2021. Архивировано 2 августа 2019 года.

- ↑ Legal issues (англ.). International Internet Preservation Consortium. Дата обращения: 16 декабря 2021. Архивировано 16 декабря 2021 года.

- ↑ Berčič, 2005, pp. 17—24.

- ↑ 1 2 Brown, 2006.

- ↑ Olson, 2009, pp. 181—196.

- ↑ Ayala, 2021, pp. 89—106.

- ↑ Brügger, 2017, pp. 45—61.

- ↑ Rogers, 2019, p. 49.

- ↑ Niels, 2021, pp. 145—168.

- ↑ Kalev Leetaru. Why Web Archives Need To Engage With Researchers (англ.). Forbes (7 мая 2019). Дата обращения: 11 декабря 2021. Архивировано 29 декабря 2021 года.

- ↑ Kalev Leetaru. Are Web Archives Failing The Modern Web: Video, Social Media, Dynamic Pages and The Mobile Web. Forbes (24 февраля 2017). Дата обращения: 11 декабря 2021. Архивировано 29 декабря 2021 года.

Литература

[править | править код]- Adoghe A., Onasoga K., Dike D., Ajayi O. Web-Archiving: techniques, challenges, and solutions (англ.). — 2013. — Vol. 5, iss. 3. — P. 598—603.

- Alam S. Mementomap: a web archive profiling framework for efficient memento routing (англ.). — 2020.

- Ayala B. When expectations meet reality: common misconceptions about web archives and challenges for scholars (англ.) // International Journal of Digital Humanities. — 2021. — Iss. 2. — P. 89—106.

- Berčič B. Protection of Personal Data and Copyrighted Material on the Web: The Cases of Google and Internet Archive (англ.) // Communications Technology Law. — 2005. — Vol. 14, iss. 1. — P. 17—24. — doi:10.1080/1360083042000325283.

- Brown A. Archiving websites a practical guide for information management professionals (англ.). — Facet publishing. — 2006. — 256 p. — ISBN 978-1-85604-553-7.

- Brügger N., Schroeder R. Live versus archive: Comparing a web archive to a population of web pages (англ.). — 2017. — P. 45—61. — doi:10.2307/j.ctt1mtz55k.8.

- Brügger N. Digital humanities and web archives: Possible new paths for combining datasets (англ.) // International Journal of Digital Humanities. — 2021. — Iss. 2. — P. 145—168.

- Broussard M. Archiving Data Journalism (англ.) // Yhe Data Journalism Handbook. — 2021. — P. 274—278. — doi:10.2307/j.ctv1qr6smr.40.

- Brunelle J., Nelson M. Evaluating the SiteStory Transactional Web Archive With the ApacheBench Tool (англ.) // ArXiv.org. — 2012.

- Costa M., Gomes D., Silva M. The evolution of web archiving (англ.) // Int J Digit Libr. — 2017. — Iss. 18. — P. 191—205. — doi:10.1007/s00799-016-0171-9.

- Dooley J.M., Farrell K., Kim T., Venlet J. Developing Web Archiving Metadata Best Practices to Meet User Needs (англ.) // Journal of Western Archives. — 2017. — Vol. 8, iss. 2.

- Hakala J. The NEWLIB harvester (англ.) // Zeitschrift für Bibliothekswesen und Bibliographie. — 2001. — Vol. 48, iss. 3. — P. 211—216.

- Giaretta D. Avoiding a Digital Dark Age for data: why publishers shoudl care about digital preservation (англ.) // Learned Publishing. — 2011. — P. 1—18.

- Kimpton M., Ubois J. Year-by-Year: From an Archive of the Internet to an Archive on the Internet // Web Archiving. — 2006. — С. 201—212.

- Masanes J. Web Archiving (англ.). — Springer. — 1998. — P. 1—234. — ISBN 3-540-23338-5.

- Mohr G., Stack M., Ranitovic I., Avery D., Kimpton M. An Introduction to Heritrix. An open source archival quality web crawler // 4th International Web Archiving Workshop. — 2004. — С. 1—15.

- Niu J. An Overview of Web Archiving (англ.) // School of Information Faculty Publications. — 2012. — P. 1—13. — doi:10.1045/march2012‐niu1.

- Ogden J., Maemura E. ‘Go fish’: Conceptualising the challenges of engaging national web archives for digital research (англ.) // International Journal of Digital Humanities. — Iss. 2. — P. 43—63. — doi:10.1007/s42803-021-00032-5.

- Olson J. Chapter 14 - The Archive Data Store (англ.) // Database Archive. — 2009. — P. 181—196. — doi:10.1016/B978-0-12-374720-4.00014-5.

- Panos P. The Internet Archive: An End to the Digital Dark Age (англ.) // Journal of Social Work Education. — 2003. — Vol. 39, iss. 2. — P. 343—347. — doi:10.1080/10437797.2003.10779139.

- Patel K., Phillips M., Caragea C., Fox N. Identifying Documents In-Scope of a Collection from Web Archives (англ.) // arXiv. — 2020.

- Pennock M. Web-Archiving (англ.). — DPC Technology Watch Report 13-01 March 2013. — 2013. — doi:10.7207/twr13-01.

- Perkel, J. The trouble with reference rot. (англ.) // Nature. — 2015. — Iss. 521. — P. 111—112. — doi:10.1038/521111a.

- Pretoro E., Geeraert F., Soyez S. Behind the scenes of web archiving metadata of harvested websites (англ.) // Trust and Understanding: the value of metadata in a digitally joined-up world. — 2013. — P. 63—74.

- Rhodes S. Breaking Down Link Rot: The Chesapeake Project Legal Information Archive's Examination of URL Stability (англ.) // Law Library Journal. — 2010. — Vol. 102, iss. 4. — P. 581—597.

- Rockwell G., Tchoh B. Archiving Database Driven Websites for Future Digital Archaeologists: The Archiving of TAPoR (англ.) // CSDH-SCHN 2020. — 2020. — doi:10.17613/v412-8896.)

- Rogers R. Periodizing Web Archiving: Biographical, Event-Based, National and Autobiographical Traditions (англ.) // The SAGE Handbook of Web History. — 2019. — P. 42—57.

- Rumianek M. Archiving and Recovering Database-driven Websites (англ.) // D-Lib Magazine. — 2013. — Vol. 19, iss. 1/2. — doi:10.1045/january2013-rumianek.

- Slania H. Online Art Ephemera: Web Archiving at the National Museum of Women in the Arts (англ.) // Art Documentation: Journal of the Art Libraries Society of North America. — 2013. — Vol. 32, iss. 1. — P. 112—126.

- Toyoda M., Kitsuregawa M. {{{заглавие}}} (англ.) // Invited Paper. — 2012. — doi:10.1109/JPROC.2012.2189920.

- Eysenbach G., Trudel M. Going, Going, Still There: Using the WebCite Service to Permanently Archive Cited Web Pages // J Med Internet Resources. — 2005. — doi:10.2196/jmir.7.5.e60.

- Zittrain J., Bowers J., Stanton C. The Paper of Record Meets an Ephemeral Web: An Examination of Linkrot and Content Drift within The New York Times (англ.) // Library Innovation Lab. — 2021.

- Webb C. Because It Belongs to All of Us: National Arrangements for Digital Preservation in Australian Libraries (англ.) // Australian Academic & Research Libraries. — 2000. — P. 154—172. — doi:10.1080/00048623.2000.10755132.

- Vlassenroot E., Chambers S., Mechant P. Web archives as a data resource for digital scholars (англ.) // International Journal of Digital Humanities. — 2019. — Vol. 1, iss. 85. — P. 85—111. — doi:10.1007/s42803-019-00007-7.

- Vlassenroot E.,Chambers S., Lieber S., Michel A., Geeraert F., Pranger J., Birkholz J. Web-archiving and social media: an exploratory analysis (англ.) // International Journal of Digital Humanities. — 2021. — Vol. 2. — P. 107—128.

- White J. Link Rot, Reference Rot, and Link Resolves (англ.) // New Top Technologies Every Librarian Needs to Know. — 2019. — P. 29—43.

- Балацкая Н.М., Мартиросова М.Б. Веб-архивирование как задача национальной и краеведческой библиографии // Библиосфера. — 2021. — № 3. — С. 12—17.

- Поврозник Г.Г. Веб-архивы в реконструкции истории виртуальных музеев: потенциал и ограничения // Вестник Пермского Университета. — 2020. — Т. 51, вып. 4. — С. 95—102.

- Редькина Н.С. Мировые тенденции развития библиотек. Оптимизм vs пессимизм (по материалам зарубежной литературы) // Библиосфера. — 2019. — Вып. 1. — С. 49—58.