Вероятностный классификатор (Fyjkxmukvmudw tlgvvnsntgmkj)

Вероятностный классификатор — классификатор, который способен предсказывать, если на входе заданы наблюдения, распределение вероятностей над множеством классов, а не только вывод наиболее подходящего класса, к которому наблюдения принадлежат. Вероятностные классификаторы обеспечивают классификацию, которая может быть полезна сама по себе[1] или когда классификаторы собираются в ансамбли.

Типы классификации

[править | править код]Формально, «обычный» классификатор — это некоторое правило или функция, которая назначает наблюдению x класс меток ŷ:

Наблюдения берутся из некоторого множества X (например, множество всех документов, или множество всех изображений), в то время класс меток образует конечное множество Y, определённое до тренировки классификатора.

Вероятностные классификаторы обобщают понятие классификаторов — вместо функций они являются условными вероятностями , что значит, что для данного классификатор назначает вероятности для всех (и сумма этих вероятностей равна единице). «Жёсткая» классификация может затем быть осуществлена с помощью правила принятия оптимальных решений[2].

то есть предсказанный класс — это класс с наибольшей вероятностью.

Бинарные вероятностные классификаторы называются в статистике также биномиальными регрессионными[англ.] моделями. В эконометрике вероятностный классификатор в общем случае называется дискретным выбором.

Некоторые классификационные модели, такие как наивный байесовский классификатор, логистическая регрессия и многослойные перцептроны (когда они тренируются с подходящими функциями потерь) естественным образом являются вероятностными. Другие модели, такие как методы опорных векторов, вероятностными не являются, но существуют методы, превращающие их в вероятностные классификаторы.

Порождающая и условная тренировки

[править | править код]Некоторые модели, такие как модель логистической регрессии тренируются условно — они оптимизируют условную вероятность непосредственно на тренировочном наборе (минимизация эмпирического риска). Другие классификаторы, такие как наивный байесовский классификатор, являются тренированными порождающими[англ.] классификаторами — во время тренировки находятся условное по классам распределение и априорный класс , а условное распределение получают с помощью байесовского правила[3].

Калибрация вероятности

[править | править код]Не все модели классификации естественным образом вероятностны, а те, которые вероятностны по своей природе, в частности, наивные байесовские классификаторы, деревья решений и методы бустинга, дают искажённые распределения вероятностей[4]. В случае деревьев решений, когда Pr(y|x) является пропорцией тренировочных выборок с меткой y в листе, которым x заканчивается, это искажение распределения возникает ввиду того, что обучающие алгоритмы, такие как C4.5 или деревья классификации и регрессии (англ. Classification and regression trees, CART) в явном виде стремятся получить однородные листья (давая вероятности, близкие к нулю или единице, а потому сильное смещение), в то время как для оценки пропорции используется лишь несколько экземпляров (высокая дисперсия)[5].

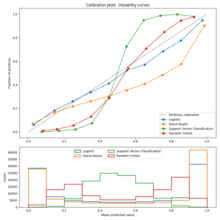

Может быть определено масштабирование с помощью калибровочного графика (называемого также диаграммой надёжности). Калибровочный график показывает пропорцию элементов в каждом классе для дорожек предсказанной вероятности или показателя (такого как искривлённое распределение вероятностей или «расстояния до гиперплоскости» (со знаком) в методе опорных векторов). Отклонения о тождественной функции указывают на плохо калиброванный классификатор, для которого предсказанные вероятности или показатели не могут быть использованы в качестве вероятностей. В этом случае можно использовать метод превращения этих показателей в должным образом калиброванный[англ.] класс вероятностей.

Для двоичного случая общим подходом является применение масштабирования по Платту[англ.], который обучает модель логистической регрессии по показателям[6]. Альтернативный метод с использованием изотонной регрессии[англ.][7] обычно лучше метода Платта, если доступен достаточно большой набор тренировлчных данных[4].

В мультиклассовом[англ.] случае можно использовать сведение к двоичным задачам с последующей одномерной калибровкой по алгоритму, как описано выше, а потом применением алгоритма попарного объединения Гесте и Тибширани[8].

Вычисление вероятностной классификации

[править | править код]Обычно используемые функции потерь для вероятностной классификации — логистическая функция потерь и показатель Бриера[англ.] между предсказанным и истинным распределением вероятностей. Первая из этих функций обычно используется для тренировки логистических моделей.

Метод, используемый для назначения показателей парам предсказанных вероятностей и актуальных дискретных исходов, так что различные методы предсказания можно было бы сравнить, называется правилом подсчёта результатов[англ.].

Примечания

[править | править код]- ↑ Hastie, Tibshirani, Friedman, 2009, с. 348.

- ↑ Bishop, 2006, с. 39–40.

- ↑ Bishop, 2006, с. 43.

- ↑ 1 2 Niculescu-Mizil, Caruana, 2005.

- ↑ Zadrozny, Elkan, 2001, с. 609–616.

- ↑ Platt, 1999, с. 61–74.

- ↑ Zadrozny, Elkan, 2002, с. 694–699.

- ↑ Hastie, Tibshirani, 1998, с. 451–471.

Литература

[править | править код]- Trevor Hastie, Robert Tibshirani, Jerome Friedman. The Elements of Statistical Learning. — 2009. Архивная копия от 26 января 2015 на Wayback Machine

- В 219 выйдет перевод книги «Основы статистического обучения: интеллектуальный анализ данных, логический вывод и прогнозирование», Тревор Хасти, Роберт Тибширани, Джером Фридман, издательство «ДИАЛЕКТИКА»

- Christopher M. Pattern Recognition and Machine Learning. — Springer, 2006. — (Information Science and Statistic).

- Книга «Распознавание образов и машинное обучение», Кристофер М. Бишоп, будет издана издательством «ДИАЛЕКТИКА» в 2019

- Alexandru Niculescu-Mizil, Rich Caruana. Predicting good probabilities with supervised learning // Proc. Int. Conf. on Machine Learning (ICML). — 2005. — ISBN 0-387-31073-8. — doi:10.1145/1102351.1102430.

- Bianca Zadrozny, Charles Elkan. Obtaining calibrated probability estimates from decision trees and naive Bayesian classifiers // Proc. 18th Int. International Conf. on Machine Learning (ICML). — San Francisco, CA: Morgan Kaufmann, 2001.

- John Platt. Probabilistic outputs for support vector machines and comparisons to regularized likelihood methods // Advances in large margin classifiers. — 1999. — Т. 10, вып. 3.

- Bianca Zadrozny, Charles Elkan. Transforming classifier scores into accurate multiclass probability estimates // Proceedings of the eighth ACM SIGKDD international conference on Knowledge discovery and data mining - KDD '02. — 2002. — ISBN 1-58113-567-X. — doi:10.1145/775047.775151.

- Trevor Hastie, Robert Tibshirani. Classification by pairwise coupling // The Annals of Statistics. — 1998. — Т. 26, вып. 2. — doi:10.1214/aos/1028144844.

Для улучшения этой статьи желательно:

|