Склонность к подтверждению своей точки зрения (Vtlkuukvm, t hk;mfyj';yunZ vfkyw mkctn [jyunx)

Склонность к подтверждению своей точки зрения (англ. confirmation bias), или предвзятость подтверждения — тенденция человека искать и интерпретировать такую информацию или отдавать предпочтение такой информации, которая согласуется с его точкой зрения, убеждением или гипотезой[Комм. 1][1]. Разновидность когнитивного искажения и систематической ошибки индуктивного мышления. Эффект проявляется сильнее в отношении эмоционально значимых вопросов и глубоко укоренившихся убеждений. Люди также склонны интерпретировать неоднозначные свидетельства таким образом, чтобы поддерживалась их точка зрения.

Предвзятым поиском, толкованием и запоминанием объясняются такие эффекты, как эффект поляризации взглядов (когда разногласия становятся ещё сильнее, несмотря на то, что сторонам были представлены одни и те же свидетельства), эффект стойкости убеждения (англ. belief perseverance, когда мнение сохраняется даже тогда, когда поддерживающие его свидетельства были опровергнуты), эффект первичности (англ. primacy effect, склонность отдавать предпочтение информации, полученной первой), иллюзорная корреляция (склонность видеть взаимосвязь между двумя явлениями или ситуациями там, где её нет).

Ряд экспериментов, проведённых в 1960-х годах, показал, что люди склонны подтверждать имеющиеся у них убеждения. Последующие исследования дали основания пересмотреть эти результаты и выдвинуть идею о склонности людей проверять их гипотезы и фокусировать внимание только на одной возможности и игнорировать альтернативные либо менее соответствующие их интересам. В некоторых ситуациях эта тенденция может искажать выводы людей. Объяснениями наблюдаемых когнитивных искажений могут быть эффект принятия желаемого за действительное и ограниченная способность человека перерабатывать информацию. Ещё одно объяснение заключается в том, что люди скорее склонны оценивать возможные потери от признания своей неправоты, вместо того чтобы рассматривать ситуацию в нейтральном, научном стиле.

Склонность к подтверждению влияет на излишнюю самоуверенность человека в собственных суждениях и может поддерживать и усиливать убеждения при получении доказательств обратного. Эти когнитивные искажения находят отражение в плохих решениях, принимаемых в политическом и организационном контекстах[2][Комм. 2].

Типы

[править | править код]Склонность к подтверждению — эффекты обработки информации, которые отличаются от эффекта поведенческого подтверждения; их также называют «самоисполняющееся пророчество», когда поведение под влиянием ожиданий приводит к тому, что эти ожидания оправдываются[3]. Некоторые психологи используют термин «склонность к подтверждению» для тенденции избегать отвержения убеждений (верований) при поиске, интерпретации или припоминании доказательств. Другие психологи ограничивают использование этого термина выборочным поиском информации[4][Комм. 3].

Предвзятый поиск информации

[править | править код]

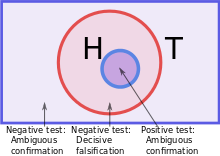

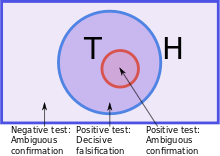

Эксперименты неоднократно показывали, что люди имеют тенденцию оценивать ту или иную гипотезу однобоко, ища доказательства, согласующиеся с их текущей гипотезой[6][7]. Вместо того чтобы искать с помощью всех имеющихся доказательств, они формулируют вопрос таким образом, чтобы получить утвердительный ответ, поддерживающий их гипотезу[8]. Они ищут последствия, которых бы ожидали, если бы их гипотеза была правильной, вместо тех, которые наступили бы, если бы она была ошибочной[8]. Например, при использовании вопросов формата «да/нет» для того, чтобы узнать число, которым, как предполагает человек, является числом «три», он может спросить: «Это нечётное число?» Люди предпочитают такой тип вопросов, называемый «положительным тестом», даже если отрицательный тест, например, вопрос «Это чётное число?», предоставит абсолютно такую же информацию[9]. Однако это не означает, что люди ищут «тесты», которые гарантируют положительный ответ. В исследованиях, где участники могли выбрать или такие «псевдотесты», или настоящие диагностические, они предпочитали диагностические[10][11].

Предпочтение «положительных тестов» само по себе не является предубеждением, поскольку они также могут быть весьма информативными[12]. Однако в сочетании с другими эффектами такая стратегия может подтвердить имеющиеся убеждения или предположения, независимо от того, являются ли они правильными[13]. В реальном мире доказательства часто сложные и смешанные. Например, противоречивые мнения об одном и том же лице могут быть подтверждены, если фокусироваться на различных аспектах его или её поведения. Поэтому поиск доказательств в подтверждение имеющейся гипотезы, скорее всего, будет успешным[13]. Формулировка вопроса может существенно изменить ответ[7]: в частности, люди, которым задали вопрос «Вы довольны вашей личной жизнью?», показывают больший уровень удовлетворённости, чем те, кого спросили «Вы не довольны Вашей личной жизнью?»[14].

Даже маленькое изменение в формулировке вопроса может влиять на то, как люди ищут ответы среди имеющейся информации, а следовательно — и на выводы, к которым они приходят. Это было продемонстрировано на примере вымышленного дела об опеке над ребёнком[15]. Участники прочитали, что один из родителей (A) был в средней степени способен к выполнению функций опекуна по многим критериям. Второй из родителей (B) имел смесь ярко выраженных хороших и плохих черт: близкие отношения с ребёнком, но работу, которая требовала командировок на длительное время. Когда респондентам задавали вопрос о том, «кто из родителей должен получить опеку над ребёнком?», большинство участников ответило, что B, учитывая преимущественно положительные черты. Однако когда задали вопрос о том, «кому из родителей следует отказать в опеке над ребёнком?», они оценивали уже отрицательные черты, и большинство ответило, что B следует отказать, что намекало, что опека должна быть предоставлена A[15].

Похожие исследования продемонстрировали, как люди предвзято занимаются поиском информации, но также то, что этот феномен может ограничиваться предоставлением преимущества настоящим диагностическим тестам. В начальном эксперименте участники оценивали другого человека по категориям личности по шкале «интроверсия — экстраверсия» на основе интервью. Они могли выбрать вопросы для интервью из предоставленного перечня. Когда человека, у которого брали интервью, представляли как интроверта, участники выбирали вопросы, которые предусматривали интроверсию, например: «Что вам неприятно в шумных вечеринках?» Когда же такого человека представляли как экстраверта, почти все вопросы предусматривали экстраверсию, например: «Что бы Вы сделали для улучшения скучной вечеринки?» Эти вопросы с подтекстом не позволяли (или давали мало шансов) человеку, у которого брали интервью, опровергнуть гипотезу о себе[16]. В более поздней версии эксперимента участникам предоставлялся менее жёсткий перечень вопросов для выбора, например: «Почему Вы уклоняетесь от социального взаимодействия?»[17]. Участники предпочитали такие в большей степени диагностические вопросы, демонстрируя лишь слабое предубеждение в пользу положительных тестов. Эта тенденция к предпочтению более диагностических тестов была подтверждена и другими исследованиями[17].

Черты личности влияют и взаимодействуют с процессом предвзятого поиска информации[18]. Люди различаются в своих способностях защищать свои отношения от внешнего воздействия в части селективного восприятия. Селективное восприятие имеет место, когда люди ищут информацию, которая скорее соответствует, а не противоречит их личным убеждениям[19]. Был проведён эксперимент, изучавший, в какой степени люди могут опровергать доказательства, противоречащие их личным убеждениям. Для формулировки доказательств более уверенные люди с большей готовностью ищут информацию, которая противоречит их личному мнению[18]. Неуверенные люди не ищут противоречивую информацию и предпочитают информацию, поддерживающую истинность их собственного мнения. Люди создают и оценивают показания в доказательствах, которые являются предвзятыми в пользу их собственных убеждений и мнений[20]. Более высокие уровни уверенности снижают степень предпочтения информации, поддерживающей собственные убеждения.

В другом эксперименте участники должны были выполнить сложную задачу по поиску правил, включавшему движение объектов с помощью компьютерного моделирования[21]. Объекты на экране компьютера двигались по определённым правилам, а участники должны были их выяснить. Участники могли «выстреливать» по экрану для проверки их гипотез. Однако, несмотря на многочисленные попытки в течение 10-часового эксперимента, никто из участников не угадал правила системы. Они преимущественно пытались подтвердить, а не опровергнуть свои гипотезы и не хотели рассматривать альтернативы. Даже после получения объективных свидетельств, противоречащих их гипотезам, они часто повторяли те же тесты. Некоторым участникам сообщили о правильном образе тестирования гипотез, однако эти знания не имели почти никакого влияния на их действия[21].

Предвзятая интерпретация

[править | править код]«Умные люди верят в странные вещи, поскольку они имеют опыт защиты убеждений, к которым пришли по неразумным причинам».

Склонность к подтверждению не ограничена поиском доказательств. Даже если два человека имеют одинаковую информацию, предвзятой может быть её интерпретация.

Команда в Стэнфордском университете провела эксперимент с участниками, имеющими сильные убеждения по вопросу смертной казни (половина участников — «за» и половина — «против»)[23][24]. Каждый участник читал описание двух исследований: сравнение штатов США с и без смертной казни и сравнение количества убийств в штате до и после введения смертной казни. После того как участники прочитали краткое описание каждого исследования, их спрашивали, не изменились ли их убеждения. После того они читали более полное описание процедуры проведения каждого из исследований и должны были оценить, было ли исследование правильно проведено и убедительно[23]. На самом деле оба исследования были придуманы, при этом половине участников сообщили, что первое из исследований поддерживает наличие эффекта сдерживания, а второе — отрицает его, а второй половине участников сказали наоборот[23][24].

Участники (и сторонники, и противники смертной казни) сообщили о небольшом изменении своих отношений в направлении выводов первого исследования, которое они прочитали. После того как они прочитали более детальное описание процедур двух исследований, почти все вернулись к своим первоначальным убеждениям, несмотря на представленные доказательства, указывая на детали, которые поддерживали их точку зрения, и отвергая всё, что ей противоречило. Участники описали исследования, поддерживавшие их точку зрения, как более надёжные, чем те, что ей противоречили, с указанием деталей, почему они так считают[23][25]. Например, сторонник смертной казни, описывая исследование, которое якобы отрицало эффект сдерживания, написал: «Исследование не покрывает достаточно длительного периода времени», тогда как противник её применения о том же исследовании сказал следующее: «Существенных доказательств, которые бы противоречили исследователям, не приведено»[23]. Результаты продемонстрировали, что люди устанавливают высокие стандарты для доказательств гипотезы, противоречащей их имеющимся убеждениям или ожиданиям. Этот эффект, известный как «склонность к отсутствию подтверждения», был доказан и другими экспериментами[26].

Другое исследование предвзятой интерпретации осуществлялось в течение кампании по выборам президента США 2004 года и включало участников, которые были сильными сторонниками какого-либо из кандидатов. Этим участникам показали противоречивые на вид пары утверждений или от кандидата-республиканца Джорджа Буша, или от кандидата-демократа Джона Керри, или от политически нейтральной публичной фигуры. Им также предоставили утверждения, которые объясняли или устраняли эту противоречивость. На основе этих трёх элементов информации участники должны были решить, является ли утверждение непоследовательными[27]:1948. В результате была получена существенная разница в оценках, когда участники с гораздо большей вероятностью оценивали утверждение «чужого» кандидата как противоречивые[27]:1951.

В этом эксперименте участники предоставляли свои оценки, находясь в МРТ, который отслеживал активность их мозга. Когда участники оценивали противоречивые утверждения своего кандидата, были возбуждены эмоциональные центры мозга. А при оценке других утверждений такого не происходило. Экспериментаторы предположили, что различные реакции на утверждение поступали не из-за пассивных ошибок в суждениях, а потому, что участники активно уменьшали когнитивный диссонанс, вызванный тем, что они прочитали об иррациональном или лицемерном поведении их любимого кандидата[27].

Предубеждения при интерпретации убеждений очень устойчивы, независимо от уровня интеллекта. Участники эксперимента сдали тест SAT (тест на поступление в колледж в США) для оценки их уровня интеллекта. После теста они ознакомились с информацией о безопасности автомобилей, в которой экспериментаторами была изменена страна происхождения авто. Участники из США высказывали своё мнение об автомобилях, которые должны быть запрещены в стране, по шестибалльной шкале, где «один» означало «однозначно да», а «шесть» — «точно нет». Сначала участники оценивали, выпустили ли бы они опасную немецкую машину на улицы Америки и опасную американскую машину на улицы Германии. Участники отметили, что опасную немецкую машину в Америке следует запретить быстрее, чем опасную американскую машину в Германии. Разница в уровне интеллекта не играла никакой роли в том, какой балл участники ставили запрету машины[20].

Предвзятая интерпретация не ограничивается эмоционально важными темами. В другом эксперименте участникам рассказали историю о краже. Они имели возможность оценить важность доказательств показания за или против вины определённого лица. Когда они делали предположения о виновности, то оценивали утверждения, поддерживавшие их гипотезу, как более важные, чем те, которые им противоречили[28].

Предвзятая память

[править | править код]Даже если люди собирают и интерпретируют информацию нейтральным образом, они всё равно могут её помнить выборочно для усиления своих ожиданий. Этот эффект называется «селективное припоминание», «подтверждающая память» или «память по доступу»[29]. Психологические теории относительно селективного припоминания различаются. Теория схем предусматривает, что информация, которая соответствует предыдущим ожиданиям, легче запоминается и сохраняется, чем информация, которая им не соответствует[30]. Некоторые альтернативные подходы считают, что неожиданная информация выделяется и поэтому запоминается[30]. Постулаты обеих этих теорий были подтверждены в различных экспериментальных условиях, а потому ни одна из теорий пока не получила преимуществ[31].

В одном из исследований участники читали информацию о женщине, которая имела смесь экстравертивного и интровертивного поведения, после чего они должны были вспомнить примеры её экстраверсии и интроверсии. Одной группе сказали, что это необходимо для оценки её пригодности на должность библиотекаря, а другой — для должности риелтора. В результате была получена существенная разница между тем, что вспоминали две этих группы: первая вспоминала больше интровертивных примеров, а вторая — примеров экстраверсии[32].

Эффект селективного припоминания также был продемонстрирован в экспериментах, которые манипулируют привлекательностью типа личности[30][33]. В одном из таких экспериментов одной группе участников привели доказательства, что экстраверты более успешны, чем интроверты, а второй группе — наоборот. В следующем, формально не связанном с первым, исследовании обе группы попросили вспомнить события из своей жизни, когда они вели интровертивно или экстравертивно. Каждая из групп предоставила больше примеров, связанных с более привлекательным типом, и вспоминала такие случаи скорее[34].

Изменения эмоционального состояния также могут влиять на припоминание[35][36]. Участники оценивали, как они чувствовали себя, когда впервые узнали, что О. Джей Симпсон был оправдан по обвинению в убийстве[35]. Они описывали свои эмоциональные реакции и уровень уверенности в вердикте через одну неделю, два месяца и один год после суда. Результаты указывали на то, что оценка участников относительно вины Симпсона менялась с течением времени. Чем больше было изменений мнений участников по вердикту, тем менее стабильными были их воспоминания по их первичным эмоциональным реакциям. Когда участники вспоминали свои первичные эмоциональные реакции через два месяца и через год, их оценка прошлой реакции была очень похожа на их оценку текущей реакции. Люди демонстрируют довольно значительное подтверждающее предубеждение при обсуждении их мнений относительно спорных вопросов[20]. Припоминание и построение опыта пересматриваются в зависимости от соответствующих эмоциональных состояний.

Склонность к подтверждению влияет на точность припоминания[36]. В одном из исследований вдовы и вдовцы оценивали силу их скорби через шесть месяцев и через 5 лет после смерти их мужа или жены. Участники отметили более высокую степень скорби через 6 месяцев по сравнению с 5 годами. Однако когда через 5 лет их спросили, как они чувствовали себя через 6 месяцев после смерти их второй половины, сила скорби, которую они вспомнили, имела высокую корреляцию с их текущими ощущениями. Было сделано предположение, что эмоциональные воспоминания вспоминаются с учётом текущего эмоционального состояния, то есть люди, вероятно, используют текущее эмоциональное состояние для анализа того, как они чувствовали себя в прошлом[35].

Ещё одно исследование показало, как выборочное припоминание может поддерживать убеждения (веру) в экстрасенсорное восприятие[37]. Людям, которые верили и не верили в такое восприятие, показали описание экспериментов с экстрасенсорным восприятием. Половине участников в каждой из этих двух групп сказали, что экспериментальные результаты подтверждают существование такого восприятия, а половине — нет. После этого при тестировании большинство участников правильно вспоминало показанный им материал, кроме веривших, прочитавших доказательства его несуществования. Эта группа помнила значительно меньше приведённой информации, а некоторые ещё и неправильно вспоминали результаты как поддерживающие экстрасенсорное восприятие[37].

Связанные эффекты

[править | править код]Поляризация мнений

[править | править код]Поляризация мнений представляет собой процесс, связанный с укреплением и увеличением противоположных точек зрения в обществе или группе людей. Этот феномен может иметь серьёзное влияние на дискуссии, принятие решений и общественный диалог[38][неавторитетный источник].

Когда люди с противоположными взглядами интерпретируют новую информацию предвзято, их взгляды могут разойтись ещё сильнее. Это называется «поляризацией отношений»[39]. Эффект был продемонстрирован в эксперименте, в котором вытягивались ряды красных и чёрных шариков из одного или другого скрытых ящиков. Участники знали, что один из ящиков содержал 60 % чёрных и 40 % красных шариков, а другой — 40 % чёрных и 60 % красных. Экспериментаторы наблюдали, что происходило, когда шарики разных цветов вытягивались по очереди, то есть в последовательности, не дающей «преимущества» какому-либо из ящиков. По мере извлечения каждого шарика участников одной из групп просили вслух называть свои суждения относительно вероятности, что шарик был извлечён из одного или другого ящика. И эти участники становились всё более уверенными в своих оценках с каждым последующим шариком — независимо от того, считали ли они, что шарик был с большей вероятностью извлечён из ящика с 60 % чёрных или ящика с 60 % красных шариков, их оценка вероятности росла. Другую группу участников попросили отметить оценку вероятности того, из какого ящика была извлечена серия шариков, только по завершении последовательности. Они не продемонстрировали эффекта поляризации, что свидетельствует, что он не обязательно возникает, когда люди просто имеют противоположные оценки, а имеет место лишь тогда, когда они открыто их называют[40].

Менее абстрактным исследованием был Стэнфордский эксперимент[уточнить] с предвзятой интерпретацией, в котором участники с ярко выраженными позициями относительно смертной казни знакомились со смешанными экспериментальными свидетельствами. Двадцать три процента участников сообщили, что их убеждения усилились, и такое изменение сильно коррелировало с их начальными отношениями[23]. В более поздних экспериментах участники также сообщали, что их мысли становились более резкими после получения неоднозначной информации, однако сравнение их отношений до и после получения новых свидетельств не показало существенных изменений, что может свидетельствовать о том, что самостоятельно оценённые изменения могут на самом деле не существовать[26][39][41]. На основе этих экспериментов Дианна Кун и Джозеф Лао сделали вывод, что поляризация является настоящим феноменом, однако далека от неизбежности и случается только в небольшом количестве случаев. Они выяснили, что такое предубеждение побуждается не только рассмотрением смешанных свидетельств, но и просто размышлениями над таким вопросом[39].

Чарльз Табер и Мильтон Лодж доказывали, что результат стэнфордской команды было трудно воспроизвести, поскольку доказательства, использованные в последующих экспериментах, были очень абстрактными или неясными для получения эмоциональной реакции. Исследование Табера и Лоджа использовало эмоционально острые для США темы контроля за оружием и позитивной дискриминации[26]. Они измеряли отношение участников этих исследований к этим вопросам до и после чтения доказательств с каждой стороны дискуссии. Две группы участников продемонстрировали поляризацию отношений: люди с сильными предварительным мнениями по этим вопросам и политически подкованные. В части этого исследования участники выбирали, какие источники информации читать, из перечня, подготовленного учёными. Например, они могли читать доказательства по вопросу контроля за оружием от Национальной стрелковой ассоциации и коалиции Брейди против оружия. Даже после инструктажа о необходимости быть нейтральными участники всё равно с большей вероятностью выбирали те доказательства, которые поддерживали их имеющиеся отношения. Такой предвзятый поиск информации коррелировал с эффектом поляризации[26].

«Эффект обратного результата» — термин, применяемый для ситуации, когда при показаниях против их убеждений люди могут отбросить эти показания и стать более уверенными[42][43]. Термин был впервые использован Брэндоном Нианом и Джейсоном Райфлером[44].

Сохранение дискредитированных убеждений

[править | править код]«Убеждения могут выдержать самые сильные логические или эмпирические возражения. Они могут пережить и даже усилиться на основе доказательств, которые, по мнению большинства беспристрастных наблюдателей, должны такие убеждения ослабить. Они даже могут пережить полное уничтожение их исходной доказательной базы».

Склонности к подтверждению могут быть использованы для объяснения, почему некоторые убеждения остаются, когда их начальные доказательства исчезают[46]. Такая продолжительность существования убеждений была продемонстрирована в серии экспериментов, которые использовали так называемую «парадигму доклада»: (1) участники читают о ненастоящих доказательствах гипотезы, измеряется изменение их отношения; (2) после этого им подробно объясняют, в чём была подделка доказательств («развенчивают»), и снова измеряют изменение их отношения, чтобы увидеть, вернулись ли их воззрения на начальный уровень[45].

Общий результат для этих экспериментов — по крайней мере часть исходного убеждения остаётся после такого «развенчания»[47]. В одном из экспериментов участников просили различить настоящие и поддельные записки самоубийц. Ответы учёных на мнения участников эксперимента давались случайным образом: части из них говорили, что они хорошо угадали, части — что плохо. И даже после того, как участникам подробно рассказали об эксперименте и случайности ответов, участники всё равно оставались под влиянием данных им ответов: они продолжали думать, что они лучше или хуже среднего справляются с такими задачами, — в зависимости от того, какой ответ они получили изначально[48].

В другом исследовании участники читали оценки работы двух пожарных и их реакции на тест по неприятию риска[45]. Эти данные были сфабрикованы таким образом, чтобы показывать отрицательную или положительную корреляцию: части участников предоставили информацию, что пожарный, который любит рисковать, имел большие успехи, чем осторожный, некоторым — наоборот[49]. Даже если бы эти данные были настоящими, две оценки являются очень плохим научным доказательством, чтобы делать выводы обо всех пожарных. Однако для участников они были субъективно убедительны[49]. Когда же участникам сказали, что данные были придуманы, их вера в связь уменьшилась, однако осталась на уровне около половины первоначального эффекта[45]. Интервью после эксперимента подтвердили, что участники поняли «развенчание» и восприняли его всерьёз; они ему верили, однако отвергали эту информацию как не согласующуюся с их личными убеждениями[49].

Предпочтение более ранней информации

[править | править код]Эксперименты показали, что информация имеет больший вес, если она получена раньше, даже когда порядок её получения не важен. Например, люди формируют более положительные впечатления о ком-либо как «разумном, трудолюбивом, импульсивном, критическом, упрямом, завистливом», чем когда те же характеристики представлены в обратном порядке[50]. Этот эффект «иррациональной первичности» независим от эффекта первичности, когда более ранние элементы (слова) в последовательности оставляют больший след в памяти[50]. Одним из объяснений этого эффекта является предвзятая интерпретация: когда человек видит первоначальное доказательство (свидетельство), оно формирует рабочую гипотезу, влияющую на то, как она интерпретирует всю последующую информацию[46].

В одной из демонстраций иррациональной первичности использовались цветные жетоны, которые были «вытянуты» из двух ящиков. Участникам говорили о распределении цветов в этих ящиках и просили оценить вероятность того, что жетон был извлечён из каждого из этих ящиков[50]. На самом деле жетоны были расположены в специальном порядке: «вытягивание» первых тридцати производилось из первого ящика, а следующих тридцати — из второго[46]. Последовательность в целом была нейтральной, поэтому логично, что оба ящика были одинаково вероятны. Однако после 60 «вытягиваний» участники эксперимента предпочитали тот ящик, который чаще фигурировал в первых 30 «вытягиваниях»[50].

Другой эксперимент включал слайд-шоу одного и того же объекта, которое сначала шло очень размыто с улучшением фокуса в каждом следующем слайде[50]. После каждого слайда участники должны были высказать свою догадку относительно изображённого объекта. Участники, чьи первые догадки были неправильными, настаивали на этих догадках, даже когда картинка уже была настолько сфокусирована, что другие люди легко узнавали этот предмет[46].

Иллюзорная связь между событиями

[править | править код]Иллюзорная корреляция — тенденция видеть связи в наборе данных, которые на самом деле отсутствуют[51]. Эта тенденция впервые была продемонстрирована в серии экспериментов в конце 1960-х годов[52]. В одном из экспериментов участники читали несколько материалов практических психологических исследований, которые включали ответы на тест Роршаха. Они сделали вывод о том, что гомосексуалы имеют большую склонность видеть в фигурах теста ягодицы или другие сексуально двусмысленные фигуры, чем гетеросексуалы. На самом деле все эти материалы исследований были полностью выдуманы, а в одной из версий эксперимента из материалов вообще получалось, что гомосексуалы видят такие фигуры в тестах менее часто, чем гетеросексуалы[51]. В опросе группа опытных психоаналитиков повторила те же иллюзорные выводы о связи между реакцией на рисунки и гомосексуальностью[51][52].

Другое исследование в течение 15 месяцев записывало симптомы пациентов с артритом и погодные условия. Почти все пациенты сообщили, что их боли были связаны с погодными условиями, хотя реальная корреляция была равна нулю[53].

Этот эффект является типом искривлённой (предвзятой) интерпретации, когда объективно нейтральные или отрицательные доказательства интерпретируются для поддержки имеющихся убеждений. Он также связан с предубеждениями в поведении по проверке гипотез[54]. При оценке связи двух событий, вроде болезни и плохой погоды, люди сильно полагаются на количество позитив-позитивных случаев: в данном примере — когда одновременно имели место боль и плохая погода. Они обращают относительно мало внимания на другие виды наблюдений (отсутствие боли и (или) хорошую погоду)[55]. Это похоже на ожидание хороших результатов при проверке гипотезы, но может также свидетельствовать о селективном припоминании, когда люди чувствуют, что два события связаны, поскольку так легче вспоминать случаи, когда они происходили одновременно[54].

История

[править | править код]Неформальные наблюдения

[править | править код]

Задолго до психологических исследований склонности к подтверждению упоминания об этом феномене можно найти у писателей, например, у древнегреческого историка Фукидида (ок. 460 до н. э. — ок. 395 до н. э.), итальянского поэта Данте Алигьери (1265—1321), английского философа и учёного Фрэнсиса Бэкона (1561—1626)[56] и русского писателя Льва Толстого (1828—1910). Фукидид в «Истории Пелопоннесской войны» писал: «… потому что это привычка человечества — подвергаться бездумной надежде на то, чего они хотят, и использовать собственные суждения, чтобы отбросить то, что им не нравится»[57]. В поэме «Божественная комедия» святой Фома Аквинский даёт совет Данте, когда они встречаются в Раю: «те, кто быстро формирует собственное мнение, могут ошибиться, и тогда привязанность к собственному мнению связывает и заключает ум»[58].

Бэкон в работе «Новый Органон» написал[59]:

Понимание человека, когда он уже пришёл к какой-то мысли … притягивает все вещи для её поддержки и согласования с ней. И хотя существует большое количество и вес аргументов с другой стороны, ими он пренебрегает или презирает или по каким-то признакам отставляет или отвергает.

Бэкон писал, что предвзятая оценка доказательств движет «всеми предрассудками, в астрологии, снах, знамениях, божественной справедливости и другому»[59].

В эссе «Что есть искусство?» Л. Н. Толстой написал[60]:

Я знаю, что большинство не только считающихся умными людьми, но действительно очень умные люди, способные понять самые трудные рассуждения научные, математические, философские, очень редко могут понять хотя бы самую простую и очевидную истину, но такую, вследствие которой приходится допустить, что составленное ими иногда с большими усилиями суждение о предмете, суждение, которым они гордятся, которому они поучали других, на основании которого они устроили всю свою жизнь, — что это суждение может быть ложно.

Исследование Вейсона по тестированию гипотез

[править | править код]Сам термин «склонность к подтверждению» был предложен английским психологом Питером Вейсоном[61]. В эксперименте, результаты которого были опубликованы в 1960 году, он потребовал от участников сформулировать правило, которое бы касалось троек чисел. В начале им сказали, что тройка (2,4,6) соответствует правилу. Участники могли предлагать собственные тройки, а экспериментатор сообщал им, соответствует такая тройка правилу или нет[62][63].

Хотя в действительности правило звучало как «любая восходящая последовательность», участникам было очень трудно его отгадать. При этом они часто предлагали более сложные правила, например: «второе число является средним между первым и третьим»[62]. Участники проверяли только тройки на положительный пример, то есть те, которые соответствовали их гипотезе относительно правила. Например, если они думали, что правило звучит как «следующее число на две единицы больше, чем предыдущее», то предлагали тройку, которая ему отвечала, например (11,13,15), а не тройку, которая ему противоречила, например (11,12,19)[64].

Вейсон верил в фальсификационизм, согласно которому научное тестирование гипотезы — это серьёзная попытка её опровергнуть, и поэтому он проинтерпретировал результаты эксперимента так, что участники предпочитали подтверждение, а не опровержение, отсюда и возник термин «склонность к подтверждению»[Комм. 4][65]. Он также использовал склонности к подтверждению для объяснения результатов своего эксперимента с задачей по выбору[66]. В этой задаче участникам предоставили частичную информацию по набору предметов, а они должны были определить, какая дополнительная информация им нужна для того, чтобы сказать, применяется ли к этому набору условное правило («Если A, то B»). Неоднократные исследования показали, что люди очень плохо справляются с различными формами этого теста, в большинстве случаев игнорируя информацию, которая могла бы потенциально отменить правило[67][68].

Критика Клеймана и Ха

[править | править код]В работе 1987 года Джошуа Клейман и Ха Ён Вон доказывали, что эксперименты Вейсона на самом деле не продемонстрировали предубеждение в пользу подтверждения. Зато они проинтерпретировали результаты как тенденцию людей делать тесты, которые согласуются с рабочей гипотезой[69], и назвали это «стратегией положительных тестов»[7]. Эта стратегия является примером эвристики — «короткого пути» при обсуждении, который не идеален, однако лёгок для реализации[1]. Для своего стандарта в тестировании гипотез Клейман и Ха использовали не фальсификационизм, а байесовскую вероятность и теорию информации. Согласно этим идеям, каждый ответ на вопрос даёт разный объём информации, зависящий от имеющихся убеждений человека. Поэтому научное тестирование гипотезы — это то, что должно принести больше информации. Поскольку состав информации зависит от первоначальных вероятностей, положительный тест может быть высоко- или неинформативным. Клейман и Ха доказывали, что когда люди думают о реалистичных проблемах, то ищут конкретный ответ с невысокой первоначальной вероятностью. В этом случае положительные тесты, как правило, более информативны, нежели отрицательные[12]. Однако в задаче Вейсона на поиск правила ответ «три числа в восходящем порядке» очень широк, поэтому положительные тесты вряд ли дадут информативные ответы. Клейман и Ха поддержали свой анализ примером эксперимента, который использовал ярлыки «DAX» и «MED» вместо «соответствует правилу» и «не соответствует правилу». Это позволило избежать предположения, что целью является найти правило с низкой вероятностью. В этой версии эксперимента участники были намного успешнее[70][71].

В свете этой и других критик фокус исследований сместился от подтверждения против опровержения к исследованию, проверяют ли люди гипотезы информативным путём или неинформативным, но положительным. Поиск «настоящей» склонности к подтверждению заставил психологов рассмотреть широкий спектр последствий обработки человеком информации[72].

Объяснения

[править | править код]Склонность к подтверждению часто определяется как результат автоматических, непреднамеренных стратегий, а не умышленного обмана[73][74]. Согласно Роберту Маккуну, большая часть предвзятой обработки информации происходит в результате комбинации «холодного» (когнитивного) и «горячего» (мотивированного, эмоционального) механизмов[75].

Когнитивные объяснения склонности к подтверждению основаны на ограничениях человеческой способности к обработке сложных задач и соответствующих сокращениях пути, при этом используемого, и называются эвристикой[76]. Например, люди могут оценивать надёжность показаний, используя эвристику доступности, — то есть то, насколько легко какая идея приходит в мнение[77]. Возможно также, что люди могут одновременно фокусироваться только на одной мысли по какому-либо вопросу, поэтому им сложно параллельно тестировать альтернативные гипотезы[78]. Другая эвристика — стратегия положительных тестов, которую обнаружили Клейман и Ха, то есть когда люди проверяют гипотезу путём изучения тех случаев, в которых они ожидают проявление характеристики или наступления события, которое они поддерживают. Эта эвристика избегает сложной или невозможной задачи выяснить, насколько диагностическим будет каждый возможный вопрос. Однако такая эвристика не полностью надёжна, поэтому люди не видят вызовов своим имеющимся убеждениям[12][79].

Мотивационные объяснения склонности к подтверждению включают влияние желания на убеждение, что иногда называют «принятием желаемого за действительное»[80][81]. Известно, что люди предпочитают приятные мысли неприятным многими путями («принцип Полианны»)[82]. При применении к аргументам или источникам доказательств такое отношение может объяснить, почему с большей вероятностью верят желанным выводам[80]. Согласно результатам экспериментов, которые манипулировали желательностью заключения, люди требуют высокого качества доказательств для неприятных идей и принимают низкий стандарт для идей, которым они предоставляют преимущество. Иными словами, для одних идей они спрашивают «Могу ли я этому верить?», а для других — «вынужден ли я этому верить?»[83][84]. И хотя постоянство (непротиворечивость) является желательной характеристикой отношений, чрезмерное стремление к постоянству — потенциальный источник предубеждения, поскольку оно может помешать человеку нейтрально оценивать новую, неожиданную информацию[80]. Социальный психолог Зива Кунда соединила когнитивную и мотивационную теорию, доказывая, что мотивация создаёт предубеждение, но именно когнитивные факторы определяют его величину[85].

Объяснения в терминах выгод и затрат предполагает, что люди не просто нейтрально проверяют гипотезы, а оценивают «стоимость» различных ошибок[86]. Используя идеи эволюционной психологии, Джеймс Фридрих предполагает, что при проверке гипотезы человек в первую очередь пытается избежать наиболее «затратных» ошибок, а не найти истину. Например, работодатели при собеседовании с потенциальным работником могут задавать односторонние вопросы, поскольку их фокус нацелен на выявление непригодных кандидатов[87]. Уточнение этой теории Яковом Тропом и Акивой Либерманом предполагает, что человек сравнивает два различных типа ошибок: принятие ложной гипотезы и отвержение истинной гипотезы. Например, если кто-то недооценит честность друга, он может отнестись к нему с подозрением и потерять дружбу; переоценка его честности также может дорого обойтись, но сравнительно меньше. В таком случае рациональным выходом является искать, оценивать и помнить честность друга предвзято в отношении его корысти[88]. Когда складывается первое впечатление о ком-либо, что он интроверт или экстраверт, вопросы, соответствующие такому впечатлению, кажутся более эмпатическими[89]. Поэтому при разговоре с предполагаемым интровертом кажется, что демонстрацией лучших социальных навыков является вопрос: «Вы чувствуете себя неловко в социальных ситуациях?», а не «Вам нравятся шумные вечеринки?». Связь между подтверждающим предубеждением и социальными навыками была подтверждена исследованием, в котором студенты знакомились с другими людьми. Студенты с высокой степенью самомониторинга, которые были более чувствительны к своему окружению и социальным нормам, задавали в большей степени соответствующие вопросы при беседе с высокостатусными членами профессорского состава университета, чем при знакомстве с такими же студентами, как они сами[89].

Психологи Дженнифер Лернер и Филипп Тетлок выделяют два разных вида процесса мышления. Пояснительное мышление нейтрально рассматривает различные точки зрения и пытается предусмотреть все возможные возражения к определённой позиции, а подтверждающее мышление пытается оправдать (подтвердить) определённую точку зрения. Лернер и Тетлок считают, что когда люди ожидают, что им потребуется обосновать свою позицию другим людям, чья позиция им уже известна, они имеют тенденцию принимать позицию, похожую на позицию этих людей, а затем используют подтверждающее мышление для усиления собственной позиции. Однако если внешняя сторона чрезмерно агрессивная или критическая, люди полностью отказываются от рассуждения и просто пытаются установить свою позицию без обоснования[90]. Лернер и Тетлок утверждают, что люди заставляют себя думать критически и логически только тогда, когда они знают заранее, что им надо будет объяснять свои мысли другим хорошо информированным людям, которые действительно заинтересованы в истине и чьи взгляды они ещё не знают[91]. Поскольку все эти условия редко совпадают, по мнению упомянутых психологов, большую часть времени люди используют подтверждающее мышление[92].

Воздействие

[править | править код]Для финансов

[править | править код]Вследствие склонности к подтверждению инвесторы могут действовать с чрезмерной уверенностью, игнорируя какие-либо сигналы о том, что их стратегии приведут к потере денег[5][93]. В исследованиях по политическим (избирательным) рынкам акций (то есть рынкам, привязанным к результатам выборов) инвесторы получали больше прибыли, если они не подвергались предубеждению. Например, участники, реагировавшие на выступление кандидата на должность нейтрально, а не как горячие сторонники, имели большую вероятность получить прибыль[94]. Для нейтрализации влияния, подтверждающего предубеждения, инвесторы могут попытаться временно стать на противоположную точку зрения[95]. В одной из техник они должны представить, что их инвестиции полностью провалились, и объяснить себе, почему так может произойти[5].

Для физического и умственного здоровья

[править | править код]Психолог Реймонд Никерсон обвиняет склонность к подтверждению в неэффективных медицинских процедурах, веками использовавшихся до появления научной медицины[96]. Если пациент выздоравливал, врачи считали лечение успешным, вместо того чтобы проверить альтернативные объяснения, например, завершившееся течение болезни[96]. Предвзятое обобщение является фактором и в современной привлекательности альтернативной медицины, чьи сторонники воспринимают неподтверждённые доказательства её положительного влияния, однако чрезвычайно критичны к научным свидетельствам[97][98][99].

Когнитивная психотерапия, разработанная Аароном Беком в начале 1960-х годов, в последнее время стала популярным подходом.[100]. Согласно Беку, фактором депрессии является предвзятая обработка информации[101]. Его подход учит людей относиться к информации беспристрастно вместо селективного усиления негативных взглядов на жизни[56]. Согласно исследованиям, фобии и ипохондрия также используют склонность к подтверждению, когда человек сталкивается с пугающей или опасной информацией[102].

Для политики и юриспруденции

[править | править код]

Никерсон доказывает, что суждения в юридическом и политическом контексте порой подсознательно предвзяты, поэтому предпочитаются выводам, которые уже были приняты судьями, судом присяжных или правительствами[103]. Поскольку доказательства или показания на суде присяжных могут быть сложными, неоднозначными, а присяжные часто принимают свои решения по вердикту достаточно рано в рамках процесса, то следует ожидать эффекта поляризации отношений. Эта гипотеза (что присяжные становятся более категоричными в своих взглядах по мере рассмотрения судом доказательств или свидетельств) была подтверждена в экспериментах с «игровыми судами» (ложные суды, которые используются для отработки адвокатами речей или для обучения студентов судебной практике)[104][105]. Склонность к подтверждению имеет влияние и в следственной системе уголовного правосудия в романо-германском праве, и сопернической (англ. adversarial) системе уголовного правосудия в англосаксонском праве[106].

Склонность к подтверждению может быть фактором в создании или продлении конфликтов — от эмоционально заряженных споров к войнам: интерпретируя доказательства и свидетельства в свою пользу, каждая из сторон конфликта может стать чрезмерно уверенной в том, что её позиция сильнее[107]. С другой стороны, склонность к подтверждению может привести к игнорированию или неправильной интерпретации признаков начинающегося или зарождающегося конфликта. Например, психологи Стюарт Сазерленд и Томас Кида, каждый в отдельности, считали, что адмирал США Хасбенд Киммэль продемонстрировал склонность к подтверждению, когда не обратил внимания на первые признаки японского нападения на Пёрл-Харбор[67][108].

Американский профессор Филипп Тетлок в течение двух десятилетий осуществлял исследования политических экспертов (было собрано 28 тысяч прогнозов) и выяснил, что в целом их прогнозы незначительно отличались от случайных и были хуже, чем компьютерный алгоритм. Он разделил экспертов на «лис», которые придерживались разнообразных гипотез, и «ежей», которые были более догматическими. В целом прогнозы «ежей» были менее точными. Тетлок объяснял их неудачу склонностью к подтверждению — в частности, их неспособностью использовать новую информацию, противоречившую их теориям[109].

Для паранормальных исследований

[править | править код]Одним из факторов привлекательности экстрасенсорных «считываний» является то, что те, кто обращается к экстрасенсам, используют склонность к подтверждению, согласовывая утверждения экстрасенса с их собственной жизнью[110]. Когда экстрасенс говорит много неоднозначных утверждений, он даёт клиенту больше возможностей найти соответствие. Это одна из техник «холодного считывания», когда экстрасенс может предоставить субъективно впечатляющее описание клиента безо всякой первичной информации о нём[110]. Известный канадско-американский иллюзионист и скептик Джеймс Рэнди сравнил расшифровку «считывания» и рассказ клиента о нём и отметил, что у клиента имело место выраженное селективное припоминание о «попаданиях»[111].

Яркой иллюстрацией склонности к подтверждению в реальном мире (а не в лаборатории) Никерсон считает нумерологическую пирамидологию (практики поиска значений и знания в пропорциях египетских пирамид)[112]. Поскольку существует значительное количество обмеров, которые можно осуществить, например, в Пирамиде Хеопса, и множество путей для их комбинирования и интерпретации, то те, кто смотрит на данные выборочно, почти на 100 % найдут впечатляющую согласованность, например, с измерениями Земли[112].

Для науки

[править | править код]Научное мышление отличается от других видов мышления поиском не только подтверждающих, но и опровергающих доказательств[113]. Однако не раз в истории науки учёные сопротивлялись новым открытиям в результате селективной интерпретации или игнорирования «неприемлемых» данных[113]. Предыдущие исследования показали, что оценка качества научных исследований особенно чувствительна к склонности к подтверждению, а именно — не один раз учёные выше оценивали исследования, результаты которых совпадали с предыдущими убеждениями этих учёных, нежели те, которые не соответствовали их убеждениям[74][114][115]. Хотя в рамках научного мышления, если исследуемый вопрос существеннее, построение эксперимента правильнее, а данные чётко и полно описаны, то результаты важны для научного общества и не должны рассматриваться с предубеждением, независимо от того, соответствуют ли они текущим теориям или нет[115].

В контексте научного исследования склонности к подтверждению могут поддерживать теории или программы исследований, даже если доказательства в их поддержку недостаточны или противоречивы[67][116]; особенно часто такое происходило в области парапсихологии[117].

Склонность к подтверждению у экспериментатора может потенциально повлиять на то, о каких данных он сообщает. Данные, которые идут вразрез с его ожиданиями, могут «отбрасываться» легче, что приводит к так называемому эффекту «ящика для документов»[118]. Для преодоления такой тенденции обучение учёных включает пути предупреждения этого предубеждения. Например, такие вещи, как планирование эксперимента для случайных контрольных проб (в сочетании с их систематическим просмотром), направлены на минимизацию источников предубеждений[118][119]. Социальный процесс рецензирования коллегами также считается путём для уменьшения влияния предубеждений отдельных учёных[120], хотя само по себе рецензирование может подвергаться воздействию таких предубеждений[115][121]. Таким образом, склонность к подтверждению может особенно вредить объективным оценкам тех результатов, которые не соответствуют гипотезе, поскольку предвзятые личности могут считать такие результаты слабыми по сути и не задумываться о необходимости пересмотра своих убеждений[114]. Учёные, предлагающие что-то новое, часто сталкиваются с сопротивлением со стороны научного сообщества, а исследования по спорным результатам часто получает разгромные рецензии[122].

Для самооценки

[править | править код]Социальные психологи идентифицировали две тенденции среди того, как люди ищут или интерпретируют информацию о себе: самоверификация, стремление закрепить или усилить имеющуюся самооценку, и самовалоризация, стремление получить положительную реакцию[123]. Обе тенденции реализуются с привлечением склонности к подтверждению. В экспериментах, когда люди получали реакцию на себя, противоречившую их самооценке, они с меньшей вероятностью обращали на неё внимание или запоминали, чем когда получали подтверждающую реакцию[124][125][126]. Они уменьшали влияние такой информации, интерпретируя её как ненадёжную[124][127][128]. Похожие эксперименты показали, что люди предпочитают положительную реакцию и людей, которые реагируют соответствующим образом, отрицательной[123].

См. также

[править | править код]Комментарии

[править | править код]- ↑ Генетик Дэвид Перкинс придумал термин «предубеждение моей стороны», когда ссылался на предпочтение «моей» стороны проблемы. (Baron 2000, С. 195)

- ↑ Текст в процитированной статье: Тухман (1984) описала форму реализации склонности к подтверждению в процессе оправдания политики, принятой правительством: «Если какая-либо политика была принята и введена, все последующие действия являются усилиями по её оправданию» (с. 245), на примере политики, которая привела к участию США в войне во Вьетнаме, где армия США присутствовала 16 лет, несмотря на многочисленные доказательства, что с самого начала это не было оправданным.

Твердолобость, источник самообмана, — это фактор, который имеет на удивление большую роль в правительстве. Он состоит из оценки ситуации в терминах ранее устоявшихся мнений о ней, полностью игнорируя или отвергая любые противоположные точки зрения. Это — действовать как хочешь, одновременно не позволяя себе отвлекаться на факты. Его вершиной является утверждение историков о Филиппе II Габсбургском, чья твердолобость превзошла твердолобость всех правителей: «ни один пример провала его политики не ставил под сомнение его веру в присущее этой политике совершенство». (с. 7)

Глупость, по её мнению, является одной из форм самообмана, характеризуется «настоянием на мыслях, которые укоренились, независимо от доказательств противного». (с. 209)

- ↑ «Предубеждение ассимиляции» — другой термин, используемый для предвзятой интерпретации информации. (Risen & Gilovich 2007, С. 113)

- ↑ Он также использовал термин «предупреждение верификации». (Poletiek 2001, С. 73)

Примечания

[править | править код]- ↑ 1 2 Plous, 1993, p. 233

- ↑ Nickerson, Raymond S. Confirmation bias: A Ubiquitous Phenomenon in Many Guises (англ.) // Review of General Psychology[англ.] : journal. — 1998. — June (vol. 2, no. 2). — P. 175—220. — doi:10.1037/1089-2680.2.2.175.

- ↑ Darley, John M.; Gross, Paget H. (2000), "A Hypothesis-Confirming Bias in Labelling Effects", in Stangor, Charles (ed.), Stereotypes and prejudice: essential readings, Psychology Press, p. 212, ISBN 978-0-86377-589-5, OCLC 42823720

- ↑ Risen & Gilovich, 2007

- ↑ 1 2 3 Zweig, Jason (November 19, 2009), "How to Ignore the Yes-Man in Your Head", Wall Street Journal, Dow Jones & Company, Архивировано из оригинала 1 марта 2010, Дата обращения: 13 июня 2010

- ↑ Nickerson, 1998, pp. 177–178

- ↑ 1 2 3 Kunda, 1999, pp. 112–115

- ↑ 1 2 Baron, 2000, pp. 162–164

- ↑ Kida, 2006, pp. 162–165

- ↑ Devine, Patricia G.; Hirt, Edward R.; Gehrke, Elizabeth M. (1990), "Diagnostic and confirmation strategies in trait hypothesis testing", Journal of Personality and Social Psychology, 58 (6), American Psychological Association: 952—963, doi:10.1037/0022-3514.58.6.952, ISSN 1939-1315

- ↑ Trope, Yaacov; Bassok, Miriam (1982), "Confirmatory and diagnosing strategies in social information gathering", Journal of Personality and Social Psychology, 43 (1), American Psychological Association: 22—34, doi:10.1037/0022-3514.43.1.22, ISSN 1939-1315

- ↑ 1 2 3 Klayman, Joshua; Ha, Young-Won (1987), "Confirmation, Disconfirmation and Information in Hypothesis Testing" (PDF), Psychological Review, 94 (2), American Psychological Association: 211—228, doi:10.1037/0033-295X.94.2.211, ISSN 0033-295X, Архивировано из оригинала (PDF) 1 октября 2011, Дата обращения: 14 августа 2009

- ↑ 1 2 Oswald & Grosjean, 2004, pp. 82–83

- ↑ Kunda, Ziva; Fong, G.T.; Sanitoso, R.; Reber, E. (1993), "Directional questions direct self-conceptions", Journal of Experimental Social Psychology, 29, Society of Experimental Social Psychology: 62—63, ISSN 0022-1031 via Fine, 2006, pp. 63–65

- ↑ 1 2 Shafir, E. (1993), "Choosing versus rejecting: why some options are both better and worse than others", Memory and Cognition, 21 (4): 546—556, doi:10.3758/bf03197186, PMID 8350746 via Fine, 2006, pp. 63–65

- ↑ Snyder, Mark; Swann, Jr., William B. (1978), "Hypothesis-Testing Processes in Social Interaction", Journal of Personality and Social Psychology, 36 (11), American Psychological Association: 1202—1212, doi:10.1037/0022-3514.36.11.1202 via Poletiek, 2001, p. 131

- ↑ 1 2 Kunda, 1999, pp. 117–118

- ↑ 1 2 Albarracin, D.; Mitchell, A.L. The Role of Defensive Confidence in Preference for Proattitudinal Information: How Believing That One Is Strong Can Sometimes Be a Defensive Weakness (англ.) // Personality and Social Psychology Bulletin[англ.] : journal. — 2004. — Vol. 30, no. 12. — P. 1565—1584. — doi:10.1177/0146167204271180.

- ↑ Fischer, P.; Fischer, Julia K.; Aydin, Nilüfer; Frey, Dieter. Physically Attractive Social Information Sources Lead to Increased Selective Exposure to Information (англ.) // Basic and Applied Social Psychology[англ.] : journal. — 2010. — Vol. 32, no. 4. — P. 340—347. — doi:10.1080/01973533.2010.519208.

- ↑ 1 2 3 Stanovich, K. E.; West, R. F.; Toplak, M. E. Myside Bias, Rational Thinking, and Intelligence (англ.) // Current Directions in Psychological Science[англ.] : journal. — 2013. — Vol. 22, no. 4. — P. 259—264. — doi:10.1177/0963721413480174.

- ↑ 1 2 Mynatt, Clifford R.; Doherty, Michael E.; Tweney, Ryan D. (1978), "Consequences of confirmation and disconfirmation in a simulated research environment", Quarterly Journal of Experimental Psychology, 30 (3): 395—406, doi:10.1080/00335557843000007

- ↑ Kida, 2006, p. 157

- ↑ 1 2 3 4 5 6 Lord, Charles G.; Ross, Lee; Lepper, Mark R. (1979), "Biased assimilation and attitude polarization: The effects of prior theories on subsequently considered evidence", Journal of Personality and Social Psychology, 37 (11), American Psychological Association: 2098—2109, doi:10.1037/0022-3514.37.11.2098, ISSN 0022-3514

- ↑ 1 2 Baron, 2000, pp. 201–202

- ↑ Vyse, 1997, p. 122

- ↑ 1 2 3 4 Taber, Charles S.; Lodge, Milton (July 2006), "Motivated Skepticism in the Evaluation of Political Beliefs", American Journal of Political Science, 50 (3), Midwest Political Science Association: 755—769, doi:10.1111/j.1540-5907.2006.00214.x, ISSN 0092-5853

- ↑ 1 2 3 Westen, Drew; Blagov, Pavel S.; Harenski, Keith; Kilts, Clint; Hamann, Stephan (2006), "Neural Bases of Motivated Reasoning: An fMRI Study of Emotional Constraints on Partisan Political Judgment in the 2004 U.S. Presidential Election" (PDF), Journal of Cognitive Neuroscience, 18 (11), Massachusetts Institute of Technology: 1947—1958, doi:10.1162/jocn.2006.18.11.1947, PMID 17069484, Архивировано (PDF) 24 марта 2012, Дата обращения: 14 августа 2009 Архивная копия от 24 марта 2012 на Wayback Machine

- ↑ Gadenne, V.; Oswald, M. (1986), "Entstehung und Veränderung von Bestätigungstendenzen beim Testen von Hypothesen [Formation and alteration of confirmatory tendencies during the testing of hypotheses]", Zeitschrift für experimentelle und angewandte Psychologie, 33: 360—374 via Oswald & Grosjean, 2004, p. 89

- ↑ Hastie, Reid; Park, Bernadette (2005), "The Relationship Between Memory and Judgment Depends on Whether the Judgment Task is Memory-Based or On-Line", in Hamilton, David L. (ed.), Social cognition: key readings, New York: Psychology Press, p. 394, ISBN 0-86377-591-8, OCLC 55078722

- ↑ 1 2 3 Oswald & Grosjean, 2004, pp. 88–89

- ↑ Stangor, Charles; McMillan, David (1992), "Memory for expectancy-congruent and expectancy-incongruent information: A review of the social and social developmental literatures", Psychological Bulletin, 111 (1), American Psychological Association: 42—61, doi:10.1037/0033-2909.111.1.42

- ↑ Snyder, M.; Cantor, N. (1979), "Testing hypotheses about other people: the use of historical knowledge", Journal of Experimental Social Psychology, 15 (4): 330—342, doi:10.1016/0022-1031(79)90042-8 via Goldacre, 2008, p. 231

- ↑ Kunda, 1999, pp. 225–232

- ↑ Sanitioso, Rasyid; Kunda, Ziva; Fong, G.T. (1990), "Motivated recruitment of autobiographical memories", Journal of Personality and Social Psychology, 59 (2), American Psychological Association: 229—241, doi:10.1037/0022-3514.59.2.229, ISSN 0022-3514, PMID 2213492

- ↑ 1 2 3 Levine, L.; Prohaska, V.; Burgess, S.L.; Rice, J.A.; Laulhere, T.M. Remembering past emotions: The role of current appraisals (англ.) // Cognition and Emotion[англ.] : journal. — 2001. — Vol. 15. — P. 393—417. — doi:10.1080/02699930125955.

- ↑ 1 2 Safer, M.A.; Bonanno, G.A.; Field, N. "It was never that bad": Biased recall of grief and long-term adjustment to the death of a spouse (англ.) // Memory : journal. — 2001. — Vol. 9, no. 3. — P. 195—203. — doi:10.1080/09658210143000065.

- ↑ 1 2 Russell, Dan; Jones, Warren H. (1980), "When superstition fails: Reactions to disconfirmation of paranormal beliefs", Personality and Social Psychology Bulletin, 6 (1), Society for Personality and Social Psychology: 83—88, doi:10.1177/014616728061012, ISSN 1552-7433 via Vyse, 1997, p. 121

- ↑ VUSI channel. Что такое поляризация мнений. Отказ от монетизации на платформе Дзен: остросоциальная тематика статей. Предупреждения и ограничения. dzen.ru (25 февраля 2024). Дата обращения: 27 февраля 2024. Архивировано 27 февраля 2024 года.

- ↑ 1 2 3 Kuhn, Deanna; Lao, Joseph (March 1996), "Effects of Evidence on Attitudes: Is Polarization the Norm?", Psychological Science, 7 (2), American Psychological Society: 115—120, doi:10.1111/j.1467-9280.1996.tb00340.x

- ↑ Baron, 2000, p. 201

- ↑ Miller, A.G.; McHoskey, J.W.; Bane, C.M.; Dowd, T.G. (1993), "The attitude polarization phenomenon: Role of response measure, attitude extremity, and behavioral consequences of reported attitude change", Journal of Personality and Social Psychology, 64 (4): 561—574, doi:10.1037/0022-3514.64.4.561

- ↑ backfire effect. The Skeptic's Dictionary. Дата обращения: 26 апреля 2012. Архивировано 6 февраля 2017 года.

- ↑ Silverman, Craig The Backfire Effect. Columbia Journalism Review (17 июня 2011). — «Коли Ваші найсильніші переконання піддаються сумніву доказами протилежного, Ваші переконання підсилюються.» Дата обращения: 1 мая 2012. Архивировано 22 декабря 2016 года.

- ↑ Nyhan, Brendan; Reifler, Jason. When Corrections Fail: The Persistence of Political Misperceptions (англ.) // Political Behavior[англ.] : journal. — 2010. — Vol. 32, no. 2. — P. 303—330. — doi:10.1007/s11109-010-9112-2. Архивировано 30 июля 2014 года.

- ↑ 1 2 3 4 Ross, Lee; Anderson, Craig A. (1982), "Shortcomings in the attribution process: On the origins and maintenance of erroneous social assessments", in Kahneman, Daniel; Slovic, Paul; Tversky, Amos (eds.), Judgment under uncertainty: Heuristics and biases, Cambridge University Press, pp. 129—152, ISBN 978-0-521-28414-1, OCLC 7578020

- ↑ 1 2 3 4 Nickerson, 1998, p. 187

- ↑ Kunda, 1999, p. 99

- ↑ Ross, Lee; Lepper, Mark R.; Hubbard, Michael (1975), "Perseverance in self-perception and social perception: Biased attributional processes in the debriefing paradigm", Journal of Personality and Social Psychology, 32 (5), American Psychological Association: 880—892, doi:10.1037/0022-3514.32.5.880, ISSN 0022-3514, PMID 1185517 via Kunda, 1999, p. 99

- ↑ 1 2 3 4 5 Baron, 2000, pp. 197–200

- ↑ 1 2 3 Fine, 2006, pp. 66–70

- ↑ 1 2 Plous, 1993, pp. 164–166

- ↑ Redelmeir, D. A.; Tversky, Amos (1996), "On the belief that arthritis pain is related to the weather", Proceedings of the National Academy of Sciences, 93 (7): 2895—2896, doi:10.1073/pnas.93.7.2895 via Kunda, 1999, p. 127

- ↑ 1 2 Kunda, 1999, pp. 127–130

- ↑ Plous, 1993, pp. 162–164

- ↑ 1 2 Baron, 2000, pp. 195–196.

- ↑ Thucydides. The Peloponnesian War, Book 4, chapter 108, section 4 Архивная копия от 4 февраля 2017 на Wayback Machine.

- ↑ Alighieri, Dante. Paradiso canto XIII: 118—120.

- ↑ 1 2 Bacon, Francis (1620). Novum Organum. reprinted in The English philosophers from Bacon to Mill (англ.) / Burtt, E. A., ed.. — N. Y.: Random House, 1939. — P. 36.. Цит. по Nickerson, 1998, p. 176.

- ↑ Лев Толстой. Что такое искусство Архивная копия от 6 сентября 2014 на Wayback Machine (1899).

- ↑ Gale, Maggie; Ball, Linden J. (2002), "Does Positivity Bias Explain Patterns of Performance on Wason's 2-4-6 task?", in Gray, Wayne D.; Schunn, Christian D. (eds.), Proceedings of the Twenty-Fourth Annual Conference of the Cognitive Science Society, Routledge, p. 340, ISBN 978-0-8058-4581-5, OCLC 469971634

- ↑ 1 2 Wason, Peter C. (1960), "On the failure to eliminate hypotheses in a conceptual task", Quarterly Journal of Experimental Psychology, 12 (3), Psychology Press: 129—140, doi:10.1080/17470216008416717, ISSN 1747-0226

- ↑ Nickerson, 1998, p. 179

- ↑ Lewicka, 1998, p. 238

- ↑ Oswald & Grosjean, 2004, pp. 79–96

- ↑ Wason, Peter C. (1968), "Reasoning about a rule", Quarterly Journal of Experimental Psychology, 20 (3), Psychology Press: 273—28, doi:10.1080/14640746808400161, ISSN 1747-0226

- ↑ 1 2 3 Sutherland, Stuart (2007), Irrationality (2nd ed.), London: Pinter and Martin, pp. 95—103, ISBN 978-1-905177-07-3, OCLC 72151566

- ↑ Barkow, Jerome H.; Cosmides, Leda; Tooby, John (1995), The adapted mind: evolutionary psychology and the generation of culture, Oxford University Press US, pp. 181—184, ISBN 978-0-19-510107-2, OCLC 33832963

- ↑ Oswald & Grosjean, 2004, pp. 81–82, 86–87

- ↑ Lewicka, 1998, p. 239

- ↑ Tweney, Ryan D.; Doherty, Michael E.; Worner, Winifred J.; Pliske, Daniel B.; Mynatt, Clifford R.; Gross, Kimberly A.; Arkkelin, Daniel L. (1980), "Strategies of rule discovery in an inference task", The Quarterly Journal of Experimental Psychology, 32 (1), Psychology Press: 109—123, doi:10.1080/00335558008248237, ISSN 1747-0226 (Experiment IV)

- ↑ Oswald & Grosjean, 2004, pp. 86–89

- ↑ Oswald & Grosjean, 2004

- ↑ 1 2 Hergovich, Schott & Burger, 2010

- ↑ Maccoun, 1998

- ↑ Friedrich, 1993, p. 298

- ↑ Kunda, 1999, p. 94

- ↑ Nickerson, 1998, pp. 198–199

- ↑ Nickerson, 1998, p. 200

- ↑ 1 2 3 Nickerson, 1998, p. 197

- ↑ Baron, 2000, p. 206

- ↑ Matlin, Margaret W. (2004), "Pollyanna Principle", in Pohl, Rüdiger F. (ed.), Cognitive Illusions: A Handbook on Fallacies and Biases in Thinking, Judgement and Memory, Hove: Psychology Press, pp. 255—272, ISBN 978-1-84169-351-4, OCLC 55124398

- ↑ Dawson, Erica; Gilovich, Thomas; Regan, Dennis T. (October 2002), "Motivated Reasoning and Performance on the Wason Selection Task" (PDF), Personality and Social Psychology Bulletin, 28 (10), Society for Personality and Social Psychology: 1379—1387, doi:10.1177/014616702236869, Архивировано из оригинала (PDF) 12 июня 2015, Дата обращения: 30 сентября 2009

- ↑ Ditto, Peter H.; Lopez, David F. (1992), "Motivated skepticism: use of differential decision criteria for preferred and nonpreferred conclusions", Journal of personality and social psychology, 63 (4), American Psychological Association: 568—584, doi:10.1037/0022-3514.63.4.568, ISSN 0022-3514

- ↑ Nickerson, 1998, p. 198

- ↑ Oswald & Grosjean, 2004, pp. 91–93

- ↑ Friedrich, 1993, pp. 299, 316–317

- ↑ Trope, Y.; Liberman, A. (1996), "Social hypothesis testing: cognitive and motivational mechanisms", in Higgins, E. Tory; Kruglanski, Arie W. (eds.), Social Psychology: Handbook of basic principles, New York: Guilford Press, ISBN 978-1-57230-100-9, OCLC 34731629 via Oswald & Grosjean, 2004, pp. 91–93

- ↑ 1 2 Dardenne, Benoit; Leyens, Jacques-Philippe (1995), "Confirmation bias as a Social Skill", Personality and Social Psychology Bulletin, 21 (11), Society for Personality and Social Psychology: 1229—1239, doi:10.1177/01461672952111011, ISSN 1552-7433

- ↑ Shanteau, James. Emerging perspectives on judgment and decision research (англ.) / Sandra L. Schneider. — Cambridge [u.a.]: Cambridge University Press, 2003. — P. 445. — ISBN 0-521-52718-X. Архивировано 26 января 2020 года.

- ↑ Haidt, Jonathan. The Righteous Mind : Why Good People are Divided by Politics and Religion (англ.). — New York: Pantheon Books[англ.], 2012. — P. 1473—1474. — ISBN 0-307-37790-3.

- ↑ Lindzey, edited by Susan T. Fiske, Daniel T. Gilbert, Gardner. The handbook of social psychology (неопр.). — 5th. — Hoboken, N.J.: Wiley, 2010. — С. 811. — ISBN 0-470-13749-5. Архивировано 26 января 2020 года.

- ↑ Pompian, Michael M. (2006), Behavioral finance and wealth management: how to build optimal portfolios that account for investor biases, John Wiley and Sons, pp. 187—190, ISBN 978-0-471-74517-4, OCLC 61864118

- ↑ Hilton, Denis J. (2001), "The psychology of financial decision-making: Applications to trading, dealing, and investment analysis", Journal of Behavioral Finance, 2 (1), Institute of Behavioral Finance: 37—39, doi:10.1207/S15327760JPFM0201_4, ISSN 1542-7579

- ↑ Krueger, David; Mann, John David (2009), The Secret Language of Money: How to Make Smarter Financial Decisions and Live a Richer Life, McGraw Hill Professional, pp. 112—113, ISBN 978-0-07-162339-1, OCLC 277205993

- ↑ 1 2 Nickerson, 1998, p. 192

- ↑ Goldacre, 2008, p. 233

- ↑ Singh, Simon; Ernst, Edzard (2008), Trick or Treatment?: Alternative Medicine on Trial, London: Bantam, pp. 287—288, ISBN 978-0-593-06129-9

- ↑ Atwood, Kimball (2004), "Naturopathy, Pseudoscience, and Medicine: Myths and Fallacies vs Truth", Medscape General Medicine, 6 (1): 33

- ↑ Neenan, Michael; Dryden, Windy (2004), Cognitive therapy: 100 key points and techniques, Psychology Press, p. ix, ISBN 978-1-58391-858-6, OCLC 474568621

- ↑ Blackburn, Ivy-Marie; Davidson, Kate M. (1995), Cognitive therapy for depression & anxiety: a practitioner's guide (2 ed.), Wiley-Blackwell, p. 19, ISBN 978-0-632-03986-9, OCLC 32699443

- ↑ Harvey, Allison G.; Watkins, Edward; Mansell, Warren (2004), Cognitive behavioural processes across psychological disorders: a transdiagnostic approach to research and treatment, Oxford University Press, pp. 172—173, 176, ISBN 978-0-19-852888-3, OCLC 602015097

- ↑ Nickerson, 1998, pp. 191–193

- ↑ Myers, D.G.; Lamm, H. (1976), "The group polarization phenomenon", Psychological Bulletin, 83 (4): 602—627, doi:10.1037/0033-2909.83.4.602 via Nickerson, 1998, pp. 193–194

- ↑ Halpern, Diane F. (1987), Critical thinking across the curriculum: a brief edition of thought and knowledge, Lawrence Erlbaum Associates, p. 194, ISBN 978-0-8058-2731-6, OCLC 37180929

- ↑ Roach, Kent (2010), "Wrongful Convictions: Adversarial and Inquisitorial Themes", North Carolina Journal of International Law and Commercial Regulation, 35, SSRN 1619124,

«И соперничающая, и следственная системы находятся под влиянием опасного туннеля или склонности к подтверждению.»

- ↑ Baron, 2000, pp. 191,195

- ↑ Kida, 2006, p. 155

- ↑ Tetlock, Philip E. (2005), Expert Political Judgment: How Good Is It? How Can We Know?, Princeton, N.J.: Princeton University Press, pp. 125—128, ISBN 978-0-691-12302-8, OCLC 56825108

- ↑ 1 2 Smith, Jonathan C. (2009), Pseudoscience and Extraordinary Claims of the Paranormal: A Critical Thinker's Toolkit, John Wiley and Sons, pp. 149—151, ISBN 978-1-4051-8122-8, OCLC 319499491

- ↑ Randi, James (1991), James Randi: psychic investigator, Boxtree, pp. 58—62, ISBN 978-1-85283-144-8, OCLC 26359284

- ↑ 1 2 Nickerson, 1998, p. 190

- ↑ 1 2 Nickerson, 1998, pp. 192–194

- ↑ 1 2 Koehler, 1993

- ↑ 1 2 3 Mahoney, 1977

- ↑ Proctor, Robert W.; Capaldi, E. John (2006), Why science matters: understanding the methods of psychological research, Wiley-Blackwell, p. 68, ISBN 978-1-4051-3049-3, OCLC 318365881

- ↑ Sternberg, Robert J. (2007), "Critical Thinking in Psychology: It really is critical", in Sternberg, Robert J.; Roediger III, Henry L.; Halpern, Diane F. (eds.), Critical Thinking in Psychology, Cambridge University Press, p. 292, ISBN 0-521-60834-1, OCLC 69423179,

«Одни из худших случаев подтверждения склонности к подтверждению наблюдаются в исследованиях парапсихологии… Здесь есть целое поле исследований без любых сильных данных в подтверждение теорий. Однако люди хотят верить, и поэтому находят пути, чтобы продолжать верить.»

- ↑ 1 2 Shadish, William R. (2007), "Critical Thinking in Quasi-Experimentation", in Sternberg, Robert J.; Roediger III, Henry L.; Halpern, Diane F. (eds.), Critical Thinking in Psychology, Cambridge University Press, p. 49, ISBN 978-0-521-60834-3

- ↑ Jüni P., Altman D. G., Egger M. Systematic reviews in health care: Assessing the quality of controlled clinical trials. (англ.) // BMJ (Clinical research ed.). — 2001. — Vol. 323, no. 7303. — P. 42—46. — PMID 11440947.

- ↑ Shermer, Michael (July 2006), "The Political Brain", Scientific American, ISSN 0036-8733, Архивировано из оригинала 19 марта 2011, Дата обращения: 14 августа 2009

- ↑ Emerson G. B., Warme W. J., Wolf F. M., Heckman J. D., Brand R. A., Leopold S. S. Testing for the presence of positive-outcome bias in peer review: a randomized controlled trial. (англ.) // Archives of internal medicine. — 2010. — Vol. 170, no. 21. — P. 1934—1939. — doi:10.1001/archinternmed.2010.406. — PMID 21098355.

- ↑ Horrobin, 1990

- ↑ 1 2 Swann, William B.; Pelham, Brett W.; Krull, Douglas S. (1989), "Agreeable Fancy or Disagreeable Truth? Reconciling Self-Enhancement and Self-Verification", Journal of Personality and Social Psychology, 57 (5), American Psychological Association: 782—791, doi:10.1037/0022-3514.57.5.782, ISSN 0022-3514, PMID 2810025

- ↑ 1 2 Swann, William B.; Read, Stephen J. (1981), "Self-Verification Processes: How We Sustain Our Self-Conceptions", Journal of Experimental Social Psychology, 17 (4), Academic Press: 351—372, doi:10.1016/0022-1031(81)90043-3, ISSN 0022-1031

- ↑ Story, Amber L. (1998), "Self-Esteem and Memory for Favorable and Unfavorable Personality Feedback", Personality and Social Psychology Bulletin, 24 (1), Society for Personality and Social Psychology: 51—64, doi:10.1177/0146167298241004, ISSN 1552-7433

- ↑ White, Michael J.; Brockett, Daniel R.; Overstreet, Belinda G. (1993), "Confirmatory Bias in Evaluating Personality Test Information: Am I Really That Kind of Person?", Journal of Counseling Psychology, 40 (1), American Psychological Association: 120—126, doi:10.1037/0022-0167.40.1.120, ISSN 0022-0167

- ↑ Swann, William B.; Read, Stephen J. (1981), "Acquiring Self-Knowledge: The Search for Feedback That Fits", Journal of Personality and Social Psychology, 41 (6), American Psychological Association: 1119—1128, doi:10.1037/0022-3514.41.6.1119, ISSN 0022-3514

- ↑ Shrauger, J. Sidney; Lund, Adrian K. (1975), "Self-evaluation and reactions to evaluations from others", Journal of Personality, 43 (1), Duke University Press: 94—108, doi:10.1111/j.1467-6494.1975.tb00574, PMID 1142062

Библиография

[править | править код]- Baron, Jonathan (2000), Thinking and deciding (3rd ed.), New York: Cambridge University Press, ISBN 0-521-65030-5, OCLC 316403966

- Fine, Cordelia (2006), A Mind of its Own: how your brain distorts and deceives, Cambridge, UK: Icon books, ISBN 1-84046-678-2, OCLC 60668289

- Friedrich, James (1993), "Primary error detection and minimization (PEDMIN) strategies in social cognition: a reinterpretation of підтверджувальне упередження phenomena", Psychological Review, 100 (2), American Psychological Association: 298—319, doi:10.1037/0033-295X.100.2.298, ISSN 0033-295X, PMID 8483985

- Goldacre, Ben (2008), Bad Science, London: Fourth Estate, ISBN 978-0-00-724019-7, OCLC 259713114

- Hergovich, Andreas; Schott, Reinhard; Burger, Christoph (2010), "Biased Evaluation of Abstracts Depending on Topic and Conclusion: Further Evidence of a підтверджувальне упередження Within Scientific Psychology", Current Psychology, 29 (3): 188—209, doi:10.1007/s12144-010-9087-5

- Horrobin, David F. (1990), "The philosophical basis of peer review and the suppression of innovation", Journal of the American Medical Association, 263 (10): 1438—1441, doi:10.1001/jama.263.10.1438, PMID 2304222

- Kida, Thomas E. (2006), Don't believe everything you think: the 6 basic mistakes we make in thinking, Amherst, New York: Prometheus Books, ISBN 978-1-59102-408-8, OCLC 63297791

- Koehler, Jonathan J. (1993), "The influence of prior beliefs on scientific judgments of evidence quality", Organizational Behavior and Human Decision Processes, 56: 28—55, doi:10.1006/obhd.1993.1044

- Kunda, Ziva (1999), Social Cognition: Making Sense of People, MIT Press, ISBN 978-0-262-61143-5, OCLC 40618974

- Lewicka, Maria (1998), "підтверджувальне упередження: Cognitive Error or Adaptive Strategy of Action Control?", in Kofta, Mirosław; Weary, Gifford; Sedek, Grzegorz (eds.), Personal control in action: cognitive and motivational mechanisms, Springer, pp. 233—255, ISBN 978-0-306-45720-3, OCLC 39002877

- Maccoun, Robert J. (1998), "Biases in the interpretation and use of research results" (PDF), Annual Review of Psychology, 49: 259—87, doi:10.1146/annurev.psych.49.1.259, PMID 15012470

- Mahoney, Michael J. (1977), "Publication prejudices: an experimental study of confirmatory bias in the peer review system", Cognitive Therapy and Research, 1 (2): 161—175, doi:10.1007/BF01173636

- Nickerson, Raymond S. (1998), "підтверджувальне упередження; A Ubiquitous Phenomenon in Many Guises", Review of General Psychology, 2 (2), Educational Publishing Foundation: 175—220, doi:10.1037/1089-2680.2.2.175, ISSN 1089-2680

- Oswald, Margit E.; Grosjean, Stefan (2004), "підтверджувальне упередження", in Pohl, Rüdiger F. (ed.), Cognitive Illusions: A Handbook on Fallacies and Biases in Thinking, Judgement and Memory, Hove, UK: Psychology Press, pp. 79—96, ISBN 978-1-84169-351-4, OCLC 55124398

- Plous, Scott (1993), The Psychology of Judgment and Decision Making, McGraw-Hill, ISBN 978-0-07-050477-6, OCLC 26931106

- Poletiek, Fenna (2001), Hypothesis-testing behaviour, Hove, UK: Psychology Press, ISBN 978-1-84169-159-6, OCLC 44683470

- Risen, Jane; Gilovich, Thomas (2007), "Informal Logical Fallacies", in Sternberg, Robert J.; Roediger III, Henry L.; Halpern, Diane F. (eds.), Critical Thinking in Psychology, Cambridge University Press, pp. 110—130, ISBN 978-0-521-60834-3, OCLC 69423179

- Vyse, Stuart A. (1997), Believing in magic: The psychology of superstition, New York: Oxford University Press, ISBN 0-19-513634-9, OCLC 35025826

- Stanovich, Keith (2009), What Intelligence Tests Miss: The Psychology of Rational Thought, New Haven (CT): Yale University Press, ISBN 978-0-300-12385-2

{{citation}}: Неизвестный параметр|laydate=игнорируется (справка); Неизвестный параметр|laysummary=игнорируется (справка) - Westen, Drew (2007), The political brain: the role of emotion in deciding the fate of the nation, PublicAffairs, ISBN 978-1-58648-425-5, OCLC 86117725

- Keohane, Joe (11 July 2010), "How facts backfire: Researchers discover a surprising threat to democracy: our brains", Boston Globe, NY Times

- Хиз, Чип и Дэн, Ловушки мышления. Как принимать решения, о которых вы не пожалеете, Издательство «Манн, Иванов и Фербер»